3 Esquemas de discretización numérica

You can know a great deal about something without writing about it. Can you ever know so much that you wouldn’t learn more from trying to explain what you know? I don’t think so. I’ve written about at least two subjects I know well—Lisp hacking and startups—and in both cases I learned a lot from writing about them.1 In both cases there were things I didn’t consciously realize till I had to explain them. And I don’t think my experience was anomalous. A great deal of knowledge is unconscious, and experts have if anything a higher proportion of unconscious knowledge than beginners.

Paul Graham, Putting Ideas into Words, 2022

Boundary conditions tend to make the theory of PDEs difficult.

Jürgen Jost, Partial Differential Equations, 2013 [8]

En el capitulo anterior hemos arribado a formulaciones matemáticas que modelan los procesos físicos de transporte y difusión de neutrones en estado estacionario mediante ecuaciones integro-diferenciales. Bajo las suposiciones que explicitamos al comienzo del capítulo 2 y asumiendo que las secciones eficaces macroscópicas son funciones del espacio y de la energía conocidas, estas ecuaciones son exactas. Para la ecuación de difusión, que es de segundo orden pero más sencilla de resolver, llegamos a

\tag{\ref{eq-difusion-ss}} \begin{gathered} - \text{div} \Big[ D(\mathbf{x}, E) \cdot \text{grad} \left[ \phi(\mathbf{x}, E) \right] \Big] + \Sigma_t(\mathbf{x}, E) \cdot \phi(\mathbf{x}, E) = \\ \int_{0}^{\infty} \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \phi(\mathbf{x}, E^\prime) \, dE^\prime + \chi(E) \int_{0}^{\infty} \nu\Sigma_f(\mathbf{x}, E^\prime) \cdot \phi(\mathbf{x}, E^\prime) \, dE^\prime + s_0(\mathbf{x}, E) \end{gathered}

y para la ligeramente más compleja ecuación de transporte linealmente anisótropa obtuvimos

\tag{\ref{eq-transporte-linealmente-anisotropica}} \begin{gathered} \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \right] + \Sigma_t(\mathbf{x}, E) \cdot \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) = \\ \frac{1}{4\pi} \cdot \int_{0}^{\infty} \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \int_{4\pi} \psi(\mathbf{x}, \hat{\mathbf{\Omega}}^\prime, E^{\prime}) \, d\hat{\mathbf{\Omega}}^\prime\, dE^\prime + \\ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \int_{0}^{\infty} \Sigma_{s_1}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \int_{4\pi} \psi(\mathbf{x}, \hat{\mathbf{\Omega}}^\prime, E^{\prime}) \cdot \hat{\mathbf{\Omega}}^\prime\, d\hat{\mathbf{\Omega}}^\prime\, dE^\prime \\ + \frac{\chi(E)}{4\pi} \int_{0}^{\infty} \nu\Sigma_f(\mathbf{x}, E^\prime) \cdot \int_{4\pi} \psi(\mathbf{x}, \hat{\mathbf{\Omega}}^\prime, E^{\prime}) \, d\hat{\mathbf{\Omega}}^\prime\, dE^\prime + s(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \end{gathered}

sobre un espacio de fases generado2 por seis escalares independientes:

- tres para el espacio \mathbf{x},

- dos para la dirección \hat{\mathbf{\Omega}} y

- uno para la energía E.

El objetivo de este capítulo es transformar estas dos ecuaciones diferenciales en derivadas parciales en sistemas de ecuaciones algebraicas de tamaño finito de forma tal que las podamos resolver con una herramienta computacional, cuya implementación describimos en el capítulo 4. Este proceso involucra inherentemente aproximaciones relacionadas a la discretización de la energía E, la dirección \hat{\mathbf{\Omega}} y el espacio \mathbf{x}, por lo que las soluciones a las ecuaciones diferenciales que podamos encontrar numéricamente serán solamente aproximaciones a las soluciones matemáticas reales. Según discutimos en la Sección 3.1, estas aproximaciones serán mejores a medida que aumentemos la cantidad de entidades discretas. Pero al mismo tiempo aumentan los recursos y costos de ingeniería asociados.

Comenzamos primero entonces introduciendo algunas propiedades matemáticas de los métodos numéricos y discutiendo cuestiones a tener en cuenta para analizarlos desde el punto de vista del gerenciamiento de proyectos de ingeniería. Pasamos luego a la discretización de las ecuaciones propiamente dicha. Primeramente discretizamos la dependencia en energía aplicando la idea de grupos discretos de energías para obtener las llamadas “ecuaciones multigrupo”. Continuamos luego por la dependencia angular de la ecuación de transporte aplicando el método de ordenadas discretas S_N. Esencialmente la idea es transformar las integrales sobre E^\prime y sobre \hat{\mathbf{\Omega}}^\prime en las dos ecuaciones 2.62 y 2.41 del principio del capítulo por sumatorias finitas.

El grueso del capítulo lo dedicamos a la discretización espacial de ambas ecuaciones, que es el aporte principal de esta tesis al problema de la resolución de las ecuaciones de transporte de neutrones a nivel de núcleo utilizando mallas no estructuradas y técnicas de descomposición de dominio para permitir la resolución de problemas de tamaño arbitrario. En la monografía [15] mostramos, para la ecuación de difusión, una derivación similar a la formulación propuesta en esta tesis basada en elementos finitos. Pero también se incluye una formulación espacial basada en volúmenes finitos. Por cuestiones de longitud, hemos decidido enfocarnos solamente en elementos finitos en esta tesis. Dejamos la extensión a volúmenes finitos y su comparación con otros esquemas como trabajos futuros.

Finalmente analizamos la forma matricial/vectorial de los tres casos de problemas de estado estacionario que resolvemos en esta tesis:

- medio no multiplicativo con fuentes independentes

- medio multiplicativo con fuentes independientes

- medio multiplicativo sin fuentes independientes

3.1 Métodos numéricos

En forma general, las ecuaciones 2.62 y 2.41 que derivamos en el capítulo anterior a partir de primeros principios están expresadas en una formulación fuerte (ver definición 3.12) y exacta

\mathcal{F}(\varphi, \Sigma) = 0 denotando con

- \varphi el flujo incógnita (\psi o \phi) “exacto”3 que depende continuamente de \mathbf{x}, E y \hat{\mathbf{\Omega}},

- \Sigma todos los datos de entrada, incluyendo el dominio espacial de dimensión D continuo U \in \mathbb{R}^D y las secciones eficaces con sus dependencias continuas de \mathbf{x}, E y \hat{\mathbf{\Omega}},

- \mathcal{F} un operador integral sobre E^\prime y \hat{\mathbf{\Omega}}^\prime y diferencial sobre \mathbf{x}

Esencialmente, en este capítulo aplicamos métodos numéricos [11] para obtener una formulación débil (ver definición 3.13) y aproximada

\mathcal{F}_N(\varphi_N, \Sigma_N) = 0 \tag{3.1} donde ahora

- \varphi_N es una aproximación discreta de tamaño N del flujo incógnita,

- \Sigma_N es una aproximación de los datos de entrada, incluyendo una discretización U_N del dominio espacial

- \mathcal{F}_N es un operador discreto de tamaño N

El tamaño N del operador discreto \mathcal{F}_N es el producto de

- la cantidad G de grupos de energías (Sección 3.2),

- la cantidad M de direcciones de vuelo discretas (Sección 3.3), y

- la cantidad J de incógnitas espaciales (Sección 3.4).

Definición 3.1 (Convergencia) Un método numérico es convergente si

\lim_{N\rightarrow \infty} || \varphi - \varphi_N || = 0 para alguna norma apropiada ||\cdot||. Por ejemplo, para la norma L_2:

\lim_{N\rightarrow \infty} \sqrt{\int_U \int_{4\pi} \int_{0}^{\infty} \left[ \varphi(\mathbf{x},\hat{\mathbf{\Omega}},E) - \varphi_N(\mathbf{x},\hat{\mathbf{\Omega}},E) \right]^2 \, dE \, d\hat{\mathbf{\Omega}}\, d^3\mathbf{x} } = 0

La convergencia y, más aún, el orden con el cual el error || \varphi - \varphi_N || converge a cero es importante al verificar la implementación computacional de un método numérico. Tanto es así que para que una herramienta computacional sea verificada en el sentido de “verificación y validación” de software, no sólo se tiene que mostrar que \lim_{N\rightarrow \infty} || \varphi - \varphi_N || = 0 sino que la tasa de disminución de este error con 1/N tiene que coincidir con el orden del método numérico (ver Sección 5.9). De todas maneras, demostrar que un método numérico genérico es convergente no es sencillo y ni siquiera posible en la mayoría de los casos. En forma equivalente, se prueban los conceptos de consistencia y estabilidad definidos a continuación y luego se utiliza el teorema de equivalencia que sigue.

Definición 3.2 (Consistencia) Un método numérico es consistente si

\lim_{N\rightarrow \infty} \mathcal{F}_N(\varphi, \Sigma) = \lim_{N\rightarrow \infty} \left[ \mathcal{F}_N(\varphi, \Sigma) - \mathcal{F}(\varphi, \Sigma) \right] = 0

dado que \mathcal{F}(\varphi, \Sigma) = 0. Es decir, si el operador discreto \mathcal{F}_N tiende al operador continuo \mathcal{F} para N\rightarrow \infty entonces el método es consistente. Más aún, si

\mathcal{F}_N(\varphi, \Sigma) = \left[ \mathcal{F}_N(\varphi, \Sigma) - \mathcal{F}(\varphi, \Sigma) \right] = 0 \quad \forall N \geq 1 entonces decimos que el método numérico es fuertemente4 o completamente5 consistente.

Definición 3.3 (Estabilidad) Un método numérico es estable si dada una perturbación pequeña \delta \Sigma_N en los datos de entrada tal que

\mathcal{F}_N(\varphi_N + \delta \varphi_N, \Sigma_N + \delta \Sigma_N) = 0 entonces la perturbación \delta \varphi_N causada en la solución también es pequeña. Formalmente, un método numérico es estable si

\forall \epsilon > 0, \exists \delta(\epsilon) > 0 : \forall \delta \Sigma_N~/~ || \delta \Sigma_N || < \delta(\epsilon) \Rightarrow || \delta \varphi_N || < \epsilon \quad \forall N \geq 1

La consistencia es relativamente sencilla de demostrar. La estabilidad es un poco más compleja, pero posible. Finalmente, la convergencia queda demostrada a partir del siguiente resultado.

Teorema 3.1 (de equivalencia de Lax-Richtmyer) Si un método numérico es consistente, entonces es convergente si y sólo si es estable. Más aún, cualesquiera dos propiedades implica la tercera.

3.1.1 Comparaciones y evaluaciones económicas

Suponiendo que disponemos de varios métodos numéricos que nos permitan calcular \varphi_N a partir de un conjunto de datos de entrada \Sigma_N sobre un cierto espacio de fases discretizado, cabría preguntarnos cuál es el más eficiente para resolver un cierto problema de ingeniería nuclear. Está claro que en este sentido, la eficiencia depende de

la exactitud de la solución \varphi_N obtenida

los recursos computacionales necesarios para obtener \varphi_N, medidos en

- tiempo total de procesamiento (CPU, GPU y/o APU)

- tiempo de pared,6 que es igual al del punto a en serie pero debería ser menor en cálculos en paralelo,

- memoria RAM,

- necesidades de almacenamiento, etc.

los recursos humanos necesarios para

- preparar \Sigma_N (pre-procesar),

- analizar \varphi_N (post-procesar), y

- llegar a conclusiones útiles.

Si bien con esta taxonomía pareciera ser que comparar métodos numéricos no debería ser muy difícil, hay detalles que deben ser tenidos en cuenta y que de hecho complican la evaluación. Por ejemplo, dado un cierto problema de análisis de reactores a nivel de núcleo, el punto 1 incluye las siguiente preguntas:

- ¿Es necesario resolver la ecuación de transporte o la ecuación de difusión es suficiente?

- ¿Cuántas direcciones discretas hay que tener en cuenta para obtener una exactitud apropiada?

Por otro lado, el punto 2 abarca cuestiones como

- ¿Es más eficiente discretizar el espacio con una formulación precisa como Galerkin que da lugar a matrices no simétricas usando pocos grados de libertad o conviene utilizar una formulación menos precisa como cuadrados mínimos que da lugar a matrices simétricas pero empleando más incógnitas espaciales?

- ¿Es preferible usar métodos directos que son robustos pero poco escalables o métodos iterativos que son escalables pero sensibles a perturbaciones?

La determinación del valor de N necesario para contar con una cierta exactitud apropiada para cada método numérico no es trivial e involucra estudios paramétricos para obtener \varphi_N vs. N. Este proceso puede necesitar barrer valores de N suficientemente grandes para los cuales haya discontinuidades en la evaluación. Por ejemplo, si se debe pasar de una sola computadora a más de una por limitaciones de recursos (usualmente memoria RAM) o si se debe pasar de una infra-estructura on-premise a una basada en la nube en un eventual caso donde se necesiten más nodos (hosts) de cálculo que los disponibles.

Finalmente, como en cualquier evaluación técnico-económica, intervienen situaciones particulares más blandas relacionadas al gerenciamiento de proyectos y a la tensión de los tres vértices del triángulo alcance-costos-tiempo, como por ejemplo:

- ¿Se necesitan resultados precisos (caros y lentos) o resultados aproximados (baratos y rápidos) son suficientes?

- ¿Se prioriza disminuir los costos (como en la mayoría de los proyectos de ingeniería) o se prioriza tener resultados en poco tiempo (e.g. Proyecto Manhattan [12])?

- ¿Cómo dependen los tiempos y los costos de la infra-estructura de los recursos computacionales?

- Si es on-premise:

- amortización de hardware

- mantenimiento de hardware

- licencias de software

- administración de software

- energía eléctrica

- Si es cloud:

- alquiler de instancias

- suscripciones a servicios

- orquestación

- Si es on-premise:

- ¿Cómo son los costos asociados a la capacitación de los ingenieros que tienen que obtener \varphi con cada método numérico?

Está claro que el análisis de todas estas combinaciones están fuera del alcance de esta tesis. De todas maneras, la herramienta computacional cuya implementación describimos en detalle en el capítulo 4 permite evaluar todos estos aspectos y muchos otros ya que, en forma resumida

- Está diseñado para ser ejecutado nativamente en la nube.7

- Permite discretizar el dominio espacial utilizando mallas no estructuradas.8

- Puede correr en paralelo en una cantidad arbitraria de computadoras.9

En particular, permite a los ingenieros nucleares comparar las soluciones obtenidas con las formulaciones S_N y de difusión al resolver un mismo problema de tamaño arbitrario. De esta forma, es posible justificar ante gerencias superiores o entes regulatorios la factibilidad (o no) de encarar un proyecto para analizar un reactor nuclear con la ecuación de difusión utilizando

- datos objetivos, y

- juicio de ingeniería.

3.2 Discretización en energía

Vamos a discretizar el dominio de la energía E \in \mathbb{R} utilizando el concepto clásico de física de reactores de grupos de energías, que llevado a conceptos más generales de matemática discreta es equivalente a integrar sobre volúmenes (intervalos en \mathbb{R}) de control y utilizar el valor medio sobre cada volumen como el valor discretizado.

En efecto, tomemos el intervalo de energías [0,E_0] donde E_0 es la mayor energía esperada de un neutrón individual. Como ilustramos en la figura 3.1, dividamos dicho intervalo en G grupos (volúmenes) no necesariamente iguales, cada uno definido por energías de corte 0=E_G < E_{G-1} < \dots < E_2 < E_1 < E_0, de forma tal que el grupo g es el intervalo [E_g,E_{g-1}].

Observación. Con esta notación, el grupo número uno siempre es el de mayor energía. A medida que un neutrón va perdiendo energía, va aumentando el número de su grupo de energía.

Definición 3.4 El flujo angular \psi_g del grupo g es

\psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) = \int_{E_g}^{E_{g-1}} \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \, dE

Definición 3.5 El flujo escalar \phi_g del grupo g es

\phi_g(\mathbf{x}) = \int_{E_g}^{E_{g-1}} \phi(\mathbf{x}, E) \, dE

Definición 3.6 El vector corriente \mathbf{J}_g del grupo g es

\mathbf{J}_g(\mathbf{x}) = \int_{E_g}^{E_{g-1}} \mathbf{J}(\mathbf{x},E) \, dE = \int_{E_g}^{E_{g-1}} \int_{4\pi} \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \cdot \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}}\, dE = \int_{4\pi} \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \cdot \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}}=

Observación. Los flujos \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) y \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) no tienen las mismas unidades. La primera magnitud tiene unidades de inversa de área por inversa de ángulo sólido por inversa de energía por inversa de tiempo (por ejemplo \text{cm}^{-2} \cdot \text{eV}^{-1} \cdot \text{s}^{-1}), mientras que la segunda es un flujo integrado por lo que sus unidades son inversa de área por inversa de ángulo sólido por inversa de tiempo (por ejemplo \text{cm}^{-2} \cdot \text{s}^{-1}). La misma idea aplica a \phi(\mathbf{x}, E) y a \phi_g(\mathbf{x}).

Los tres objetivos de discretizar la energía en G grupos son

- transformar la dependencia continua del flujo angular \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) con la energía E en G funciones \psi_g(\mathbf{x},\hat{\mathbf{\Omega}}) y del flujo escalar \phi(\mathbf{x}, E) en G funciones \phi_g(\mathbf{x}),

- reemplazar las integrales sobre la variable continua E^\prime por sumatorias finitas sobre el índice g^\prime, y

- re-escribir las ecuaciones de difusión y transporte en función de los flujos de grupo (\psi_g(\mathbf{x},\hat{\mathbf{\Omega}}) en transporte y \phi_g(\mathbf{x}) en difusión)

Para ilustrar la idea, prestemos atención al término de absorción total de la ecuación de transporte \Sigma_t \cdot \psi. El objetivo es integrarlo con respecto a E entre E_g y E_{g-1} y escribirlo como el producto de una sección eficaz total asociada al grupo g por el flujo angular \psi_g de la definición 3.4:

\int_{E_g}^{E_{g-1}} \Sigma_t(\mathbf{x}, E) \cdot \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \, dE = \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \tag{3.2}

De la misma manera, para la ecuación de difusión quisiéramos que

\int_{E_g}^{E_{g-1}} \Sigma_t(\mathbf{x}, E) \cdot \phi(\mathbf{x}, E) \, dE = \Sigma_{t g}(\mathbf{x}) \cdot \phi_g(\mathbf{x})

Según la definición 3.4, la sección eficaz total \Sigma_{t g} media en el grupo g debe ser

\Sigma_{t g}(\mathbf{x}) = \frac{\displaystyle \int_{E_g}^{E_{g-1}} \Sigma_t(\mathbf{x}, E) \cdot \phi(\mathbf{x}, E) \, dE}{\displaystyle \int_{E_g}^{E_{g-1}} \phi(\mathbf{x}, E) \, dE} con lo que no hemos ganado nada ya que llegamos a una condición tautológica donde el parámetro que necesitamos para no tener que conocer la dependencia explícita del flujo con la energía depende justamente de dicha dependencia. Sin embargo —y es ésta una de las ideas centrales del cálculo y análisis de reactores— podemos suponer que el cálculo de celda (Sección 2.5.2) es capaz de proveernos las secciones eficaz macroscópicas multigrupo para el reactor que estamos modelando de forma tal que, desde el punto de vista del cálculo de núcleo, \Sigma_{t g} y todas las demás secciones eficaces macroscópicas son distribuciones conocidas del espacio \mathbf{x}.

Para analizar la sección eficaz de \nu-fisiones, integremos el término de fisión de la ecuación de transporte entre las energías E_{g-1} y E_g e igualémoslo a una sumatoria de productos \nu\Sigma_{fg^\prime} \cdot \phi_{g^\prime}10

\int_{E_{g-1}}^{E_g} \frac{\chi(E)}{4\pi} \cdot \int_0^\infty \nu\Sigma_f(\mathbf{x},E^\prime) \cdot \phi(\mathbf{x}, E^\prime) \, dE^\prime \, dE = \frac{\chi_g}{4\pi} \cdot \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) \tag{3.3}

entonces

\chi_g = \int_{E_{g-1}}^{E_g} \chi(E) \, dE \tag{3.4} y

\nu\Sigma_{f g}(\mathbf{x}) = \frac{\displaystyle \int_{E^\prime_g}^{E^\prime_{g-1}} \nu\Sigma_f(\mathbf{x}, E^\prime) \cdot \phi(\mathbf{x}, E^\prime) \, dE^\prime}{\displaystyle \int_{E^\prime_g}^{E^\prime_{g-1}} \phi(\mathbf{x}, E^\prime) \, dE^\prime}

Para el término de scattering isotrópico, requerimos que

\int_{E_{g-1}}^{E_g} \frac{1}{4\pi} \cdot \int_{0}^{\infty} \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \phi(\mathbf{x},E^\prime) \, dE^\prime \, dE = \frac{1}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) \tag{3.5} entonces

\Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) = \frac{\displaystyle \int_{E_{g-1}}^{E_g} \int_{E^\prime_{g-1}}^{E^\prime_g} \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \phi(\mathbf{x},E^\prime) \,dE}{\displaystyle \int_{E^\prime_{g-1}}^{E^\prime_g} \phi(\mathbf{x},E^\prime) \, dE^\prime}

Observación. Necesitamos una doble integral sobre E y sobre E^\prime porque \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) es una sección eficaz diferencial y tiene unidades de inversa de longitud por inversa de ángulo sólido por inversa de energía.

Un análisis similar para el término de scattering linealmente anisótropo

\int_{E_{g-1}}^{E_g} \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \int_{0}^{\infty} \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \mathbf{J}(\mathbf{x},E^\prime) \, dE^\prime \, dE = \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \mathbf{J}_{g^\prime}(\mathbf{x}) \tag{3.6} arrojaría la necesidad de pesar la sección eficaz diferencial con la corriente \mathbf{J} en lugar de con el flujo escalar \phi, dejando una expresión sin sentido matemático como

\Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) = \frac{\displaystyle \int_{E_{g-1}}^{E_g} \int_{E^\prime_{g-1}}^{E^\prime_g} \Sigma_{s_1}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \mathbf{J}(\mathbf{x},E^\prime) \,dE}{\displaystyle \int_{E^\prime_{g-1}}^{E^\prime_g} \mathbf{J}(\mathbf{x},E^\prime) \, dE^\prime} a menos que tanto numerador como denominador tengan sus elementos proporcionales entre sí y la división se tome como elemento a elemento. Usualmente se desprecia la diferencia entre corriente y flujo y podemos utilizar el flujo para pesar el término de scattering anisótropo:

\Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \approx \frac{\displaystyle \int_{E_{g-1}}^{E_g} \int_{E^\prime_{g-1}}^{E^\prime_g} \Sigma_{s_1}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \phi(\mathbf{x},E^\prime) \,dE}{\displaystyle \int_{E^\prime_{g-1}}^{E^\prime_g} \phi(\mathbf{x},E^\prime) \, dE^\prime}

Integremos ahora la ecuación de transporte ecuación 2.41 con respecto a E entre E_g y E_{g-1}:

\begin{gathered} \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \int_{E_g}^{E_{g-1}} \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \, dE \right] + \int_{E_g}^{E_{g-1}} \Sigma_t(\mathbf{x}, E) \cdot \psi(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \, dE = \\ \int_{E_g}^{E_{g-1}} \frac{1}{4\pi} \cdot \int_{0}^{\infty} \Sigma_{s_0}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \phi(\mathbf{x}, E^{\prime}) \, dE^\prime + \\ \int_{E_g}^{E_{g-1}} \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \int_{0}^{\infty} \Sigma_{s_1}(\mathbf{x}, E^{\prime} \rightarrow E) \cdot \mathbf{J}(\mathbf{x}, E^{\prime}) \, dE^\prime + \\ \int_{E_g}^{E_{g-1}} \frac{\chi(E)}{4\pi} \int_{0}^{\infty} \int_{4\pi} \nu\Sigma_f(\mathbf{x}, E^\prime) \cdot \phi(\mathbf{x}, E^\prime) \, dE^\prime \, dE + \int_{E_g}^{E_{g-1}} s(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \, dE \end{gathered}

Definición 3.7 Definimos la fuente de neutrones independientes del grupo g como

s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) = \int_{E_g}^{E_{g-1}} s(\mathbf{x}, \hat{\mathbf{\Omega}}, E) \, dE

Definición 3.8 Definimos el momento de orden cero de las fuentes independientes del grupo g como

s_{0g}(\mathbf{x}) = \int_{E_g}^{E_{g-1}} s_0(\mathbf{x}, E) \, dE

Teniendo en cuenta las definiciones

- 3.4 (flujo angular del grupo g)

- 3.5 (flujo escalar del grupo g)

- 3.6 (corriente del grupo g)

- 3.7 (fuente del grupo g)

y las ecuaciones

- 3.2 (ritmo de absorciones)

- 3.3 (ritmo de fisiones)

- 3.4 (espectro de fisiones)

- 3.5 (scattering isotrópico)

- 3.6 (scattering linealmente anisótropo)

obtenemos las G ecuaciones de transporte multigrupo

\begin{gathered} \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] + \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) = \frac{1}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) + \\ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \mathbf{J}_{g^\prime}(\mathbf{x}) + \frac{\chi_g}{4\pi} \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) + s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \end{gathered} \tag{3.7} donde las incógnitas son \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) para g=1,\dots,G

Procediendo de forma análoga para la ecuación de difusión ecuación 2.62, primero integrándola con respecto a E entre E_{g-1} y E_g y luego teniendo en cuenta las definiciones

podemos obtener la ecuación de difusión multigrupo

\begin{gathered} - \text{div} \Big[ D_g(\mathbf{x}) \cdot \text{grad} \left[ \phi_g(\mathbf{x}) \right] \Big] + \Sigma_{t g}(\mathbf{x}) \cdot \phi_g(\mathbf{x}) = \\ \sum_{g^\prime = 1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) + \chi_g \sum_{g^\prime = 1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x})+ s_{0g}(\mathbf{x}) \end{gathered} \tag{3.8} donde ahora las incógnitas son \phi_g(\mathbf{x}) para g=1,\dots,G,

Observación. El coeficiente de difusión D_g del grupo g proviene de calcular las secciones eficaces \Sigma_{tg}, \Sigma_{st} y el coseno medio de scattering \mu_{0g} del grupo g y reemplazar la definición 2.17 por

D_g(\mathbf{x}) = \frac{1}{3 \left[ \Sigma_{tg}(\mathbf{x}) - \mu_{0g}(\mathbf{x}) \cdot \Sigma_{s_t g}(\mathbf{x}) \right]}

Observación. Matemáticamente, la aproximación multigrupo es equivalente a discretizar el dominio de la energía con un esquema de volúmenes finitos con la salvedad de que no hay operadores diferenciales con respecto a la variable E sino que el acople entre volúmenes se realiza en forma algebraica. Dicho acople no es necesariamente entre primeros vecinos solamente sino que es arbitrario, i.e. un neutrón puede pasar del grupo 1 al G, o viceversa, o de un grupo arbitrario g^\prime a otro grupo g.

Observación. Dado que en las ecuaciones multigrupo 3.7 y 3.8 la discretización es estrictamente algebraica y deliberadamente tautológica, la consistencia es teóricamente fuerte ya que el operador discretizado coincide con el operador continuo incluso para un único grupo de energías G=1. De hecho las ecuaciones multigrupo se basan solamente en definiciones. En la práctica, la consistencia depende del cálculo a nivel de celda de la Sección 2.5.2.

3.3 Discretización en ángulo

Para discretizar la dependencia espacial de la ecuación de transporte multigrupo 3.7 aplicamos el método de ordenadas discretas o S_N, discutido en la literatura tradicional de física de reactores. En esta tesis lo derivamos al integrar las ecuaciones multigrupo continuas en \hat{\mathbf{\Omega}} sobre volúmenes de control finitos como si fuese un esquema numérico basado en el método de volúmenes finitos. De hecho, en este caso, los volúmenes finitos son áreas \Delta \hat{\mathbf{\Omega}}_m discretas de la esfera unitaria donde cada una de ellas tiene asociadas

- un peso w_m

- una dirección particular \hat{\mathbf{\Omega}}_m, y

- una fracción de total de área unitaria \Delta \hat{\mathbf{\Omega}}_m/4\pi

para m=1,\dots,M. Nuevamente el acople entre volúmenes de control es algebraico y no necesariamente a primeros vecinos.

Observación. La cantidad \Delta \hat{\mathbf{\Omega}}_m es un escalar ya que representa una porción de área de la esfera unitaria alrededor del versor \hat{\mathbf{\Omega}}_m.

Teorema 3.2 (de cuadratura sobre la esfera unitaria) La integral de una función escalar f(\hat{\mathbf{\Omega}}) de cuadrado integrable sobre todas las direcciones \hat{\mathbf{\Omega}} es igual a 4\pi veces la suma de un conjunto de M pesos w_m normalizados tal que \sum w_m = 1, multiplicados por M valores medios \left\langle f(\hat{\mathbf{\Omega}})\right\rangle_m asociados a M direcciones \hat{\mathbf{\Omega}}_m donde cada una de las cuales tiene asociada también una porción \Delta \hat{\mathbf{\Omega}}_m de la esfera unitaria tal que su unión es 4\pi y su intersección es cero:

\int_{4\pi} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}= 4\pi \cdot \sum_{w=1}^M w_m \cdot \left\langle f(\hat{\mathbf{\Omega}})\right\rangle_m

El peso w_m es

w_m = \frac{1}{4\pi} \cdot \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}= \frac{\Delta \hat{\mathbf{\Omega}}_m}{4\pi}

Prueba. Comenzamos escribiendo la integral sobre 4\pi como una suma para m=1,\dots,M

\int_{4\pi} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}= \sum_{m=1}^M \int_{\Delta \hat{\mathbf{\Omega}}_m} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}

Multiplicamos y dividimos por \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}= 4\pi \cdot w_m

\sum_{m=1}^M \int_{\Delta \hat{\mathbf{\Omega}}_m} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}} = \sum_{m=1}^M \frac{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}}{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}} \cdot \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}} = \sum_{m=1}^M \frac{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}}{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}} \cdot 4\pi \, w_m

Si llamamos \left\langle f(\hat{\mathbf{\Omega}})\right\rangle_{\hat{\mathbf{\Omega}}_m} al valor medio de f en \Delta \hat{\mathbf{\Omega}}_m

\left\langle f(\hat{\mathbf{\Omega}})\right\rangle_{\hat{\mathbf{\Omega}}_m} = \frac{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}}{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}} entonces se sigue la tesis del teorema.

Definición 3.9 El flujo angular \psi_{mg} del grupo g asociado a la ordenada discreta m es igual al valor medio del flujo angular \psi_g del grupo g (definido en la definición 3.4) alrededor de la dirección \hat{\mathbf{\Omega}}_m:

\psi_{mg}(\mathbf{x}) = \left\langle \psi_g(\mathbf{x},\hat{\mathbf{\Omega}})\right\rangle_{\hat{\mathbf{\Omega}}_m} = \frac{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} \psi_g(\mathbf{x},\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}}{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}}

Observación. Esta vez \psi_{mg} sí tiene la mismas unidades que \psi_{g}.

Corolario 3.1 La integral del flujo escalar sobre la porción \Delta \hat{\mathbf{\Omega}}_m de la esfera unitaria es 4\pi veces el producto w_m \cdot \psi_{mg}:

\int_{\Delta \hat{\mathbf{\Omega}}_m} \psi_g(\mathbf{x},\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}} = \psi_{mg}(\mathbf{x}) \cdot \Delta \hat{\mathbf{\Omega}}_m = 4\pi \cdot w_m \cdot \psi_{mg}(\mathbf{x})

Corolario 3.2 El flujo escalar \phi_g del grupo g es igual a

\phi_g(\mathbf{x}) = \int_{4\pi} \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}= 4\pi \sum_{m=1}^M w_m \cdot \psi_{mg}(\mathbf{x})

Re-escribamos primero la ecuación 3.7 de transporte multigrupo \tag{\ref{eq-transportemultigrupo}} \begin{gathered} \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] + \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) = \frac{1}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) + \\ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \mathbf{J}_{g^\prime}(\mathbf{x}) + \frac{\chi_g}{4\pi} \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) + s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \end{gathered}

en función de los flujos angulares \psi_{mg} usando la definición 3.9 y explicitando el termino de la corriente como la integral del producto \psi_{g^\prime} \cdot \hat{\mathbf{\Omega}} según la definición 3.6

\begin{gathered} \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] + \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) = \\ \frac{1}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot 4\pi \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) + \\ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} \int_{\hat{\mathbf{\Omega}}_{m^\prime}} \psi_{g^\prime}(\mathbf{x},\hat{\mathbf{\Omega}}) \cdot \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}}+\\ \frac{\chi_g}{4\pi} \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x})\cdot 4\pi \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) + s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \end{gathered}

Ahora cancelamos los factores 4\pi en los términos de scattering lineal y fisión, integramos todos los términos con respecto a \hat{\mathbf{\Omega}} sobre \Delta \hat{\mathbf{\Omega}}_m y los analizamos uno por uno:

\begin{gathered} \underbrace{\int_{\hat{\mathbf{\Omega}}_m} \left\{ \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] \right\} \, d\hat{\mathbf{\Omega}}}_\text{advección} + \underbrace{\int_{\hat{\mathbf{\Omega}}_m} \left\{ \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right\} \, d\hat{\mathbf{\Omega}}}_\text{absorción total} = \\ \underbrace{\int_{\hat{\mathbf{\Omega}}_m} \left\{ \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right\} \, d\hat{\mathbf{\Omega}}}_\text{scattering isotrópico} + \\ \underbrace{\int_{\hat{\mathbf{\Omega}}_m} \left\{ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} \int_{\hat{\mathbf{\Omega}}_{m^\prime}} \psi_{g^\prime}(\mathbf{x},\hat{\mathbf{\Omega}}^\prime) \cdot \hat{\mathbf{\Omega}}^\prime \, d\hat{\mathbf{\Omega}}^\prime \right\} \, d\hat{\mathbf{\Omega}}}_\text{scattering linealmente anisótropo} +\\ \underbrace{\int_{\hat{\mathbf{\Omega}}_m} \left\{ \chi_g \cdot \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right\} \, d\hat{\mathbf{\Omega}}}_\text{fisión} + \underbrace{\int_{\hat{\mathbf{\Omega}}_m} \left\{ s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right\} \, d\hat{\mathbf{\Omega}}}_\text{fuentes independientes} \end{gathered} \tag{3.9}

Comencemos por el termino de advección, revirtiendo el teorema 2.9

\begin{aligned} \int_{\hat{\mathbf{\Omega}}_m} \left\{ \hat{\mathbf{\Omega}}\cdot \text{grad} \left[ \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] \right\} \, d\hat{\mathbf{\Omega}} &= \int_{\hat{\mathbf{\Omega}}_m} \text{div} \left[ \hat{\mathbf{\Omega}}\cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] \, d\hat{\mathbf{\Omega}} \\ &= \text{div} \left[ \int_{\hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}\right] \end{aligned}

Prestemos atención a la integral. Supongamos que el flujo angular es constante a trozos11 dentro de cada área \Delta \hat{\mathbf{\Omega}}_m. Entonces este valor constante es igual al valor medio de \psi en \Delta \hat{\mathbf{\Omega}}_m

\psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) = \left\langle \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right\rangle_{\hat{\mathbf{\Omega}}_m} = \psi_{mg}(\mathbf{x}) \quad \text{si $\hat{\mathbf{\Omega}}\in \Delta \hat{\mathbf{\Omega}}_m$}

En estas condiciones, \psi puede salir de la integral

\int_{\hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}} \approx \psi_{mg}(\mathbf{x}) \cdot \int_{\hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}}

Definición 3.10 Llamamos \hat{\mathbf{\Omega}}_m a la dirección que resulta ser el valor medio \left\langle \hat{\mathbf{\Omega}}\right\rangle_{\hat{\mathbf{\Omega}}_m} de todas las direcciones integradas en el área \Delta \hat{\mathbf{\Omega}}_m sobre la esfera unitaria, es decir

\hat{\mathbf{\Omega}}_m = \left\langle \hat{\mathbf{\Omega}}\right\rangle_{\hat{\mathbf{\Omega}}_m} = \frac{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}}}{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}}

Corolario 3.3 La integral del versor \hat{\mathbf{\Omega}} sobre la fracción \Delta \hat{\mathbf{\Omega}}_m de la esfera unitaria es igual al producto de \hat{\mathbf{\Omega}}_m por \Delta \hat{\mathbf{\Omega}}_m:

\int_{\Delta \hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}} = \hat{\mathbf{\Omega}}_m \cdot \Delta \hat{\mathbf{\Omega}}_m

Corolario 3.4 La integral del producto del versor \hat{\mathbf{\Omega}} con el flujo angular del grupo g sobre \Delta \hat{\mathbf{\Omega}}_m es aproximadamente igual al producto \psi_{mg} \cdot \Delta \hat{\mathbf{\Omega}}_m:

\int_{\hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}} \approx \hat{\mathbf{\Omega}}_m \cdot \psi_{mg}(\mathbf{x}) \cdot \Delta \hat{\mathbf{\Omega}}_m

Podemos volver a aplicar el teorema 2.9 para escribir el término de advección como

\begin{aligned} \text{div} \left[ \int_{\hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}\right] & \approx \text{div} \left[ \hat{\mathbf{\Omega}}_m \cdot \psi_{mg}(\mathbf{x}) \cdot \Delta \hat{\mathbf{\Omega}}_m \right] \\ & \approx \hat{\mathbf{\Omega}}_m \cdot \text{grad} \left[ \psi_{mg}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m \\ \end{aligned} \tag{3.10}

Pasemos ahora al término de absorciones totales de la ecuación 3.9. La sección eficaz no depende de \hat{\mathbf{\Omega}} por lo que puede salir fuera de la integral

\int_{\hat{\mathbf{\Omega}}_m} \left\{ \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right\} \, d\hat{\mathbf{\Omega}}= \Sigma_{t g}(\mathbf{x}) \cdot \int_{\hat{\mathbf{\Omega}}_m} \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}

Por el corolario 3.1 la última integral es \psi_{mg} \cdot \Delta \hat{\mathbf{\Omega}}_m, entonces

\int_{\hat{\mathbf{\Omega}}_m} \left[ \Sigma_{t g}(\mathbf{x}) \cdot \psi_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right] \, d\hat{\mathbf{\Omega}}= \left[ \Sigma_{t g}(\mathbf{x}) \cdot \psi_{mg}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m \tag{3.11}

El término de scattering isotrópico queda

\int_{\hat{\mathbf{\Omega}}_m} \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \, d\hat{\mathbf{\Omega}} = \left[ \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m \tag{3.12} ya que el integrando no depende de \hat{\mathbf{\Omega}}.

El integrando del término de scattering linealmente anisótropo sí depende de \hat{\mathbf{\Omega}}.

\int_{\hat{\mathbf{\Omega}}_m} \left[ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} \int_{\hat{\mathbf{\Omega}}_{m^\prime}} \psi_{g^\prime}(\mathbf{x},\hat{\mathbf{\Omega}}^\prime) \cdot \hat{\mathbf{\Omega}}^\prime \, d\hat{\mathbf{\Omega}}^\prime \right] \, d\hat{\mathbf{\Omega}}

Primero notamos que el corolario 3.4 nos indica, de manera aproximada, el resultado de la integral sobre \hat{\mathbf{\Omega}}_{m^\prime}: \hat{\mathbf{\Omega}}_{m^\prime} \psi_{m^\prime g^\prime} \Delta\hat{\mathbf{\Omega}}_{m^\prime}. A su vez, \Delta\hat{\mathbf{\Omega}}_{m^\prime} = 4\pi w_{m^\prime}, por lo que

\begin{gathered} \int_{\hat{\mathbf{\Omega}}_m} \left[ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} 4\pi \cdot w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \cdot \hat{\mathbf{\Omega}}_{m^\prime} \right] \, d\hat{\mathbf{\Omega}} = \\ 3 \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \cdot \hat{\mathbf{\Omega}}_{m^\prime} \int_{\hat{\mathbf{\Omega}}_m} \hat{\mathbf{\Omega}}\, d\hat{\mathbf{\Omega}} \end{gathered}

Una vez mas, la integral sobre \hat{\mathbf{\Omega}}_m ya la hemos resuelto (exactamente) en el corolario 3.3, y es igual a \hat{\mathbf{\Omega}}_m \cdot \Delta \hat{\mathbf{\Omega}}_m. Entonces el término de scattering linealmente anisótropo es aproximadamente igual a \begin{gathered} \int_{\hat{\mathbf{\Omega}}_m} \left[ \frac{3 \cdot \hat{\mathbf{\Omega}}}{4\pi} \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} \int_{\hat{\mathbf{\Omega}}_{m^\prime}} \psi_{g^\prime}(\mathbf{x},\hat{\mathbf{\Omega}}^\prime) \cdot \hat{\mathbf{\Omega}}^\prime \, d\hat{\mathbf{\Omega}}^\prime \right] \, d\hat{\mathbf{\Omega}} \approx \\ \left[ 3 \cdot \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \left( \hat{\mathbf{\Omega}}_{m} \cdot \hat{\mathbf{\Omega}}_{m^\prime} \right) \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m \end{gathered} \tag{3.13}

El término de fisiones es similar al de scattering isotrópico en el sentido de que el integrando no depende de \hat{\mathbf{\Omega}} entonces su integral sobre \Delta \hat{\mathbf{\Omega}}_m es directamente

\int_{\hat{\mathbf{\Omega}}_m} \chi_g \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \, d\hat{\mathbf{\Omega}} = \left[ \chi_g \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m \tag{3.14}

Para completar el análisis de la ecuación 3.9, en el término de las fuentes independientes usamos el concepto de valor medio

\int_{\hat{\mathbf{\Omega}}_m} s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}} = \left\langle s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \right\rangle_{\hat{\mathbf{\Omega}}_m} \cdot \Delta \hat{\mathbf{\Omega}}

Definición 3.11 En forma análoga a la definición 3.9, definimos a la fuente independiente del grupo g en la dirección m como

s_{mg}(\mathbf{x}) = \left\langle s(\mathbf{x},\hat{\mathbf{\Omega}})\right\rangle_{\hat{\mathbf{\Omega}}_m} = \frac{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} s_g(\mathbf{x},\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}}{ \displaystyle \int_{\Delta \hat{\mathbf{\Omega}}_m} d\hat{\mathbf{\Omega}}}

El término de fuentes independientes es entonces

\int_{\hat{\mathbf{\Omega}}_m} s_g(\mathbf{x}, \hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}} = s_{mg}(\mathbf{x}) \cdot \Delta \hat{\mathbf{\Omega}}_m \tag{3.15}

Juntemos ahora las ecuaciones

- 3.10 (advección)

- 3.11 (absorciones)

- 3.12 (scattering isotrópico)

- 3.13 (scattering linealmente anisótropo)

- 3.14 (fisiones)

- 3.15 (fuentes independientes)

para re-escribir la ecuación 3.9 como

\begin{gathered} \left[ \hat{\mathbf{\Omega}}_m \cdot \text{grad} \left[ \psi_{mg}(\mathbf{x}) \right] \right] \cdot \Delta \hat{\mathbf{\Omega}}_m + \left[ \Sigma_{t g}(\mathbf{x}) \cdot \psi_{mg}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m = \\ \left[ \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m + \\ \left[ 3 \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \left( \hat{\mathbf{\Omega}}_{m} \cdot \hat{\mathbf{\Omega}}_{m^\prime} \right) \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m + \\ \left[ \chi_g \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \sum_{m^\prime=1} w_{m^\prime} \cdot \psi_{m^\prime g^\prime}(\mathbf{x}) \right] \cdot \Delta \hat{\mathbf{\Omega}}_m + s_{mg}(\mathbf{x}) \cdot \Delta \hat{\mathbf{\Omega}}_m \end{gathered}

Dividiendo ambos miembros por \Delta \hat{\mathbf{\Omega}} obtenemos las MG ecuaciones diferenciales de transporte en G grupos de energías y M direcciones angulares, según la discretización angular denominada en la literatura “ordenadas discretas”

\begin{gathered} \hat{\mathbf{\Omega}}_m \cdot \text{grad} \left[ \psi_{mg}(\mathbf{x}) \right] + \Sigma_{t g}(\mathbf{x}) \cdot \psi_{mg}(\mathbf{x}) = \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \sum_{m^\prime=1} w_{m^\prime} \psi_{m^\prime g^\prime}(\mathbf{x}) + \\ 3 \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \sum_{m^\prime=1} w_{m^\prime} \left( \hat{\mathbf{\Omega}}_{m} \cdot \hat{\mathbf{\Omega}}_{m^\prime} \right) \psi_{m^\prime g^\prime}(\mathbf{x}) + \chi_g \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \sum_{m^\prime=1} w_{m^\prime} \psi_{m^\prime g^\prime}(\mathbf{x}) + s_{mg}(\mathbf{x}) \end{gathered} \tag{3.16}

Observación. El único operador diferencial que aparece en la ecuación 3.16 es el gradiente espacial del flujo angular \psi_{mg} del grupo g en la dirección m en el término de advección.

Observación. Todos los operadores integrales que estaban presentes en la ecuación 2.41 han sido reemplazados por sumatorias finitas.

Observación. La única aproximación numérica que tuvimos que hacer para obtener la ecuación 3.16 a partir de la ecuación 3.7 fue suponer que el flujo angular \psi_g es uniforme a trozos en cada segmento de área \Delta \hat{\mathbf{\Omega}}_m en los términos de

- absorciones totales (ecuación 3.11), y

- scattering linealmente anisótropo (ecuación 3.13).

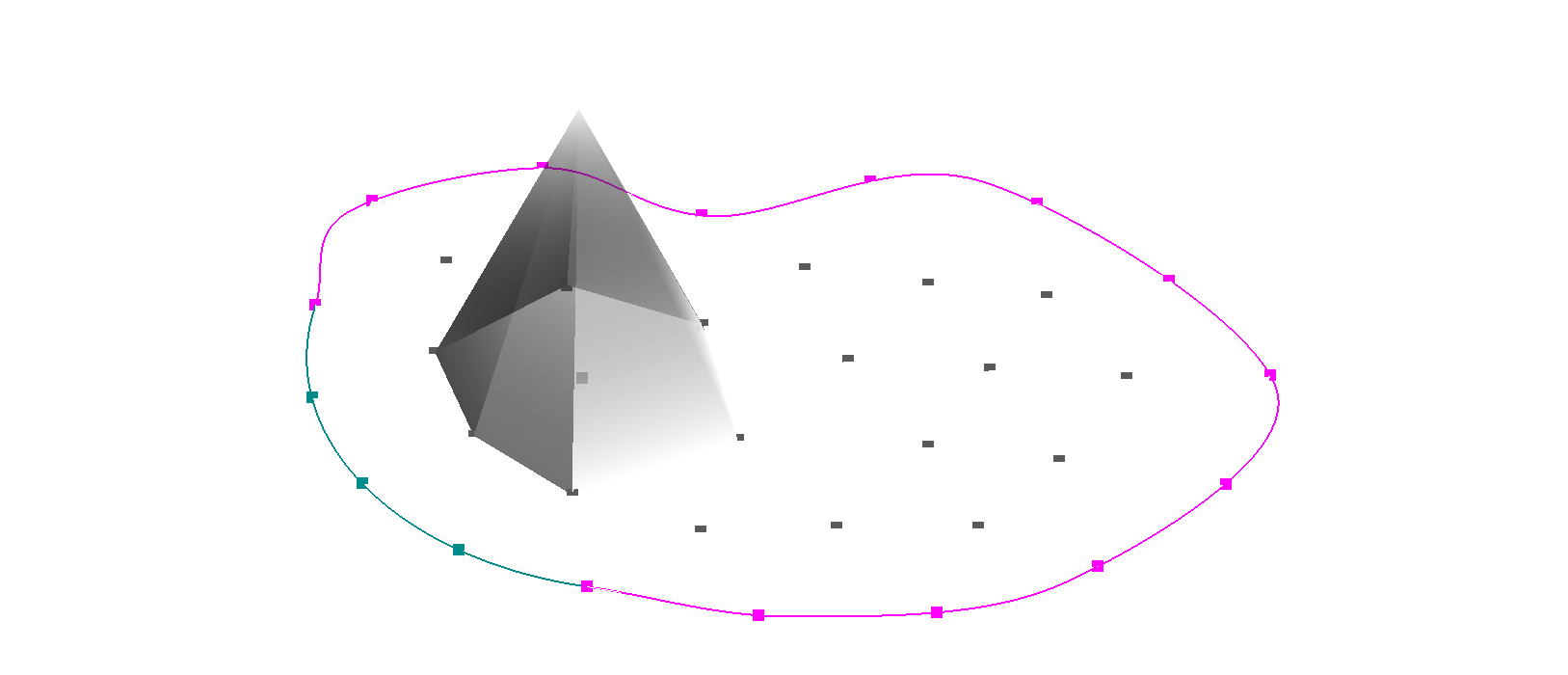

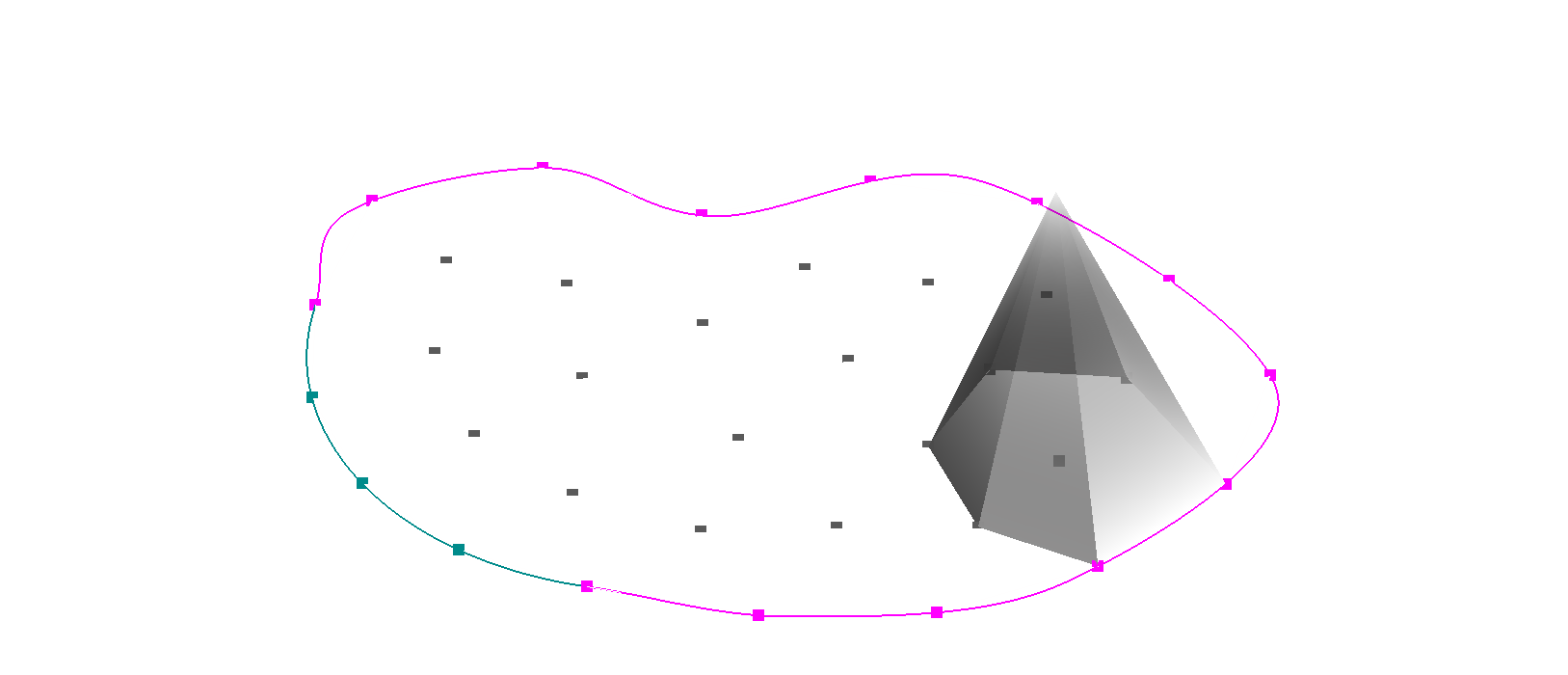

Por ejemplo, la figura 3.2 ilustra un caso en el que cada octante de la esfera unitaria está dividido en tres áreas iguales, dando lugar a M = 3 \times 8 = 24 direcciones. En cada una de las áreas mostradas, asumimos que el flujo angular \psi(\mathbf{x},\hat{\mathbf{\Omega}}) es uniformemente igual a \psi_{mg}(\mathbf{x}), siendo \mathbf{x} en este caso la posición del centro de la esfera unidad. Esta suposición es usual en los esquemas basados en el método de volúmenes finitos.

Observación. El esquema numérico es consistente ya que en el límite \Delta \hat{\mathbf{\Omega}}_m \rightarrow d\hat{\mathbf{\Omega}}_m la suposición es exacta y el operador discretizado coincide con el operador continuo.

3.3.1 Conjuntos de cuadratura

Para completar el método de las ordenadas discretas debemos especificar M pares de direcciones y pesos (\hat{\mathbf{\Omega}}_m, w_m) para m=1,\dots,M. En tres dimensiones, si utilizamos M direcciones tales que

M = N\cdot(N+2) \tag{3.17} decimos que estamos implementando el método de ordenadas discretas S_N. Esta relación numérica entre N y M es histórica y en esta tesis la mantenemos.

Las direcciones \hat{\mathbf{\Omega}}_m = [\hat{\Omega}_{mx} \, \hat{\Omega}_{my} \, \hat{\Omega}_{mz}]^T deben ser versores unitarios tales que

\hat{\Omega}_{mx}^2 + \hat{\Omega}_{my}^2 + \hat{\Omega}_{mz}^2 = 1 \tag{3.18} y para poder aplicar el teorema 3.2, los pesos w_m deben estar normalizados a uno, es decir

\sum_{m=1}^M w_m = 1

Existen varias maneras de elegir los M pares de forma tal de cumplir estas dos condiciones. En primer lugar, para poder poner condiciones de contorno de simetría en planos paralelos a los tres planos coordinados x-y, x-z e y-z requerimos que si la dirección \hat{\mathbf{\Omega}}= [\hat{\Omega}_{x} \, \hat{\Omega}_{y} \, \hat{\Omega}_{z}]^T con \hat{\Omega}_{x} > 0, \hat{\Omega}_{y} >0 y \hat{\Omega}_{z} > 0 pertenece al conjunto de cuadratura, entonces también tienen que estar las siguientes siete direcciones

\begin{aligned} \begin{bmatrix} +\hat{\Omega}_{x} & +\hat{\Omega}_{y} & -\hat{\Omega}_{z} \end{bmatrix}^T \\ \begin{bmatrix} +\hat{\Omega}_{x} & -\hat{\Omega}_{y} & +\hat{\Omega}_{z} \end{bmatrix}^T \\ \begin{bmatrix} +\hat{\Omega}_{x} & -\hat{\Omega}_{y} & -\hat{\Omega}_{z} \end{bmatrix}^T \\ \begin{bmatrix} -\hat{\Omega}_{x} & +\hat{\Omega}_{y} & +\hat{\Omega}_{z} \end{bmatrix}^T \\ \begin{bmatrix} -\hat{\Omega}_{x} & +\hat{\Omega}_{y} & -\hat{\Omega}_{z} \end{bmatrix}^T \\ \begin{bmatrix} -\hat{\Omega}_{x} & -\hat{\Omega}_{y} & +\hat{\Omega}_{z} \end{bmatrix}^T \\ \begin{bmatrix} -\hat{\Omega}_{x} & -\hat{\Omega}_{y} & -\hat{\Omega}_{z} \end{bmatrix}^T \\ \end{aligned}

Luego es suficiente definir las N(N+2)/8 direcciones del primero de los ocho octantes y luego permutar los signos para obtener las direcciones correspondientes a los otros siete octantes. En este trabajo utilizamos la cuadratura de nivel simétrico [9] o de simetría completa [14] en la que las direcciones son simétricas en cada octante. Consiste en tomar tres cosenos directores \mu_i, \mu_j y \mu_k de un conjunto de N/2 valores positivos y permutarlos de todas las maneras posibles para obtener N(N+2)/8 combinaciones como ilustramos en la figura 3.3 y continuamos discutiendo a continuación.

Teorema 3.3 En la cuadratura de nivel simétrico, no todos los N/2 posibles cosenos directores son independientes. Para S_2 hay una única dirección posible. Para N >2 sólo uno de los cosenos directores es independiente. El resto de los valores depende del primero.

Prueba. Para N=2 hay una única dirección posible en cada octante que proviene de un único cosenos director \mu_1 ya que N/2=1. Luego \hat{\mathbf{\Omega}}_1 = [\mu_1 ~ \mu_1 ~ \mu_1]^T. Para preservar la condición de normalización, debe ser \mu_1 = 1/\sqrt{3}.

Para N>2, sean \mu_1 \le \mu_2 \le \dots < \mu_{N/2} los posibles cosenos directores del conjunto. Supongamos que para la dirección m tenemos \hat{\Omega}_{mx} = \mu_i, \hat{\Omega}_{my} = \mu_j y \hat{\Omega}_{mz} = \mu_k. Entonces, por el requerimiento de normalización de la ecuación 3.18 debemos tener

\mu_i^2 + \mu_j^2 + \mu_k^2 = 1 \tag{3.19}

Tomemos ahora otra dirección diferente m^\prime pero manteniendo el primer componente \hat{\Omega}_{m^\prime x} = \mu_i y haciendo que \hat{\Omega}_{m^\prime y} = \mu_{j+1}. Para poder satisfacer la ecuación 3.19, debido a que \mu_{j+1}>\mu_{j} entonces \hat{\Omega}_{m^\prime z} = \mu_{k-1} ya que \mu_{k-1}<\mu_k. Entonces

\mu_i^2 + \mu_{j+1}^2 + \mu_{k-1}^2 = 1 \tag{3.20}

De las ecuaciones 3.19 y 3.20 obtenemos

\mu_{j+1}^2 - \mu_{j} = \mu_{k}^2 - \mu_{k-1}^2

Como esta condición debe cumplirse para todo j y para todo k, entonces

\mu_i^2 = \mu_{i-1} + C para todo 1 < i \leq N/2, con C una constante a determinar. Luego el i-ésimo coseno director es

\mu_i^2 = \mu_{1} + C \cdot (i-1)

Si tomamos \hat{\Omega}_{mx} = \hat{\Omega}_{my} = \mu_1 y \hat{\Omega}_{mz}=\mu_{N/2}, por la condición de magnitud unitaria debe ser

2\mu_1^2 + \mu_{N/2}^2 = 1 de donde podemos determinar la constante C como

C = \frac{2 \cdot (1 - 3\mu_1^2)}{N-2}

Finalmente, una vez seleccionado el coseno director \mu_1, podemos calcular el resto de los N/2-1 valores como

\mu_{i} = \sqrt{\mu_1^2 + (2 - 6\mu_1^2) \cdot \frac{(i-1)}{N-2}} para i=2,\dots,N/2.

| S_2 | |

S_4 | |

| S_6 | |

S_8 | |

| S_{10} | |

S_{12} | |

| S_{14} | |

S_{16} | |

Observación. Si el primer coseno director \mu_1 es cercano a cero, las direcciones tienden a formar un cluster alrededor de los polos. Si el primer coseno director \mu_1 es cercano a 1/\sqrt{3}, las direcciones tienden a formar un cluster alrededor del centro de cada octante.

Si miráramos el octante desde la dirección [1/\sqrt{3}~1/\sqrt{3}~1/\sqrt{3}]^T como en la segunda columna de la figura 3.3 y le asignáramos el mismo entero a cada dirección que sea una permutación de los mismos tres cosenos directores, veríamos lo que indica la tabla 3.1. Las condiciones de simetría requieren que los pesos w_m y w_{m^\prime} asociados a dos direcciones \boldsymbol{\hat\Omega}_m y \boldsymbol{\hat\Omega}_{m^\prime} cuyos cosenos directores son permutaciones entre sí deban ser iguales. Por lo tanto, los enteros de la tabla 3.1 terminan indicando el índice del peso a utilizar.

Observación. Para N=2 el triángulo de la tabla 3.1 tiene N/2=1 fila. Para cada nuevo N, se agrega una fila con N/2 nuevas direcciones. Entonces la cantidad de direcciones en un octante para S_N es

\frac{\frac{N}{2} \left( \frac{N}{2}+1 \right) }{2} = \frac{\frac{1}{2} \cdot N \cdot \frac{1}{2} \left( N+2 \right) }{2} = \frac{N \cdot (N+2)}{8} de donde sigue la ecuación 3.17.

La elección de los w_m debe ser tal que la cuadratura

\int_{4\pi} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}\approx 4\pi \cdot \sum_{w=1}^M w_m \cdot \left\langle f(\hat{\mathbf{\Omega}})\right\rangle_m del teorema teorema 3.2 arroje los resultados más precisos posibles en la ecuación de transporte de neutrones. En este sentido, dos condiciones importantes son las siguientes.

Dado que la corriente neta se aproxima como

\mathbf{J}_g(\mathbf{x}) \approx \sum_{m=1}^M w_m \cdot \hat{\mathbf{\Omega}}_m \cdot \phi_{mg}(\mathbf{x}) entonces para poder recuperar una corriente neta igual a cero para un flujo angular uniforme debemos tener

\sum_{m=1}^M w_m \cdot \hat{\mathbf{\Omega}}_m \cdot = 0

Para poder recuperar el resultado

\psi_{mg}(\mathbf{x}) \approx \frac{1}{4\pi} \phi_{mg}(\mathbf{x}) + 3 \cdot \hat{\mathbf{\Omega}}_m \cdot \mathbf{J}_{mg}(\mathbf{x}) entonces

\sum_{m=1}^M w_m \cdot \hat{\mathbf{\Omega}}_m^2 \cdot = \frac{1}{3}

Observación. Para extender las N(N+2)/8 direcciones a los demás cuadrantes, podemos notar que si asignamos un índice n a cada uno de los ocho octantes de la siguiente manera:

- x>0, y>0, z>0

- x<0, y>0, z>0

- x>0, y<0, z>0

- x<0, y<0, z>0

- x>0, y>0, z<0

- x<0, y>0, z<0

- x>0, y<0, z<0

- x<0, y<0, z<0

entonces el desarrollo binario del índice n tiene tres bits y éstos indican si hubo un cambio de signo o no en cada uno de los tres ejes con respecto al primer cuadrante, que corresponde a n=0. De esta manera, es posible generar las direcciones \boldsymbol{\hat{\Omega}}_m para m=N(N+2)/8+1, N(N+2) a partir de las direcciones del primer cuadrante \boldsymbol{\hat{\Omega}}_j para j=1,N(N+2)/8 con el siguiente algoritmo

donde

- el símbolo “et”

&indica el operador binarioANDy - el signo de pregunta

?el operador ternario de decisión.

El cálculo detallado de los pesos está fuera del alcance de esta tesis. La herramienta computacional tiene cargados el primer coseno director de cada N y los pesos reportados en las referencias [9], [14]. Consultar el código fuente de la implementación descripta en el capítulo 4 para ver los detalles algorítmicos y numéricos.

3.3.1.1 Dos dimensiones

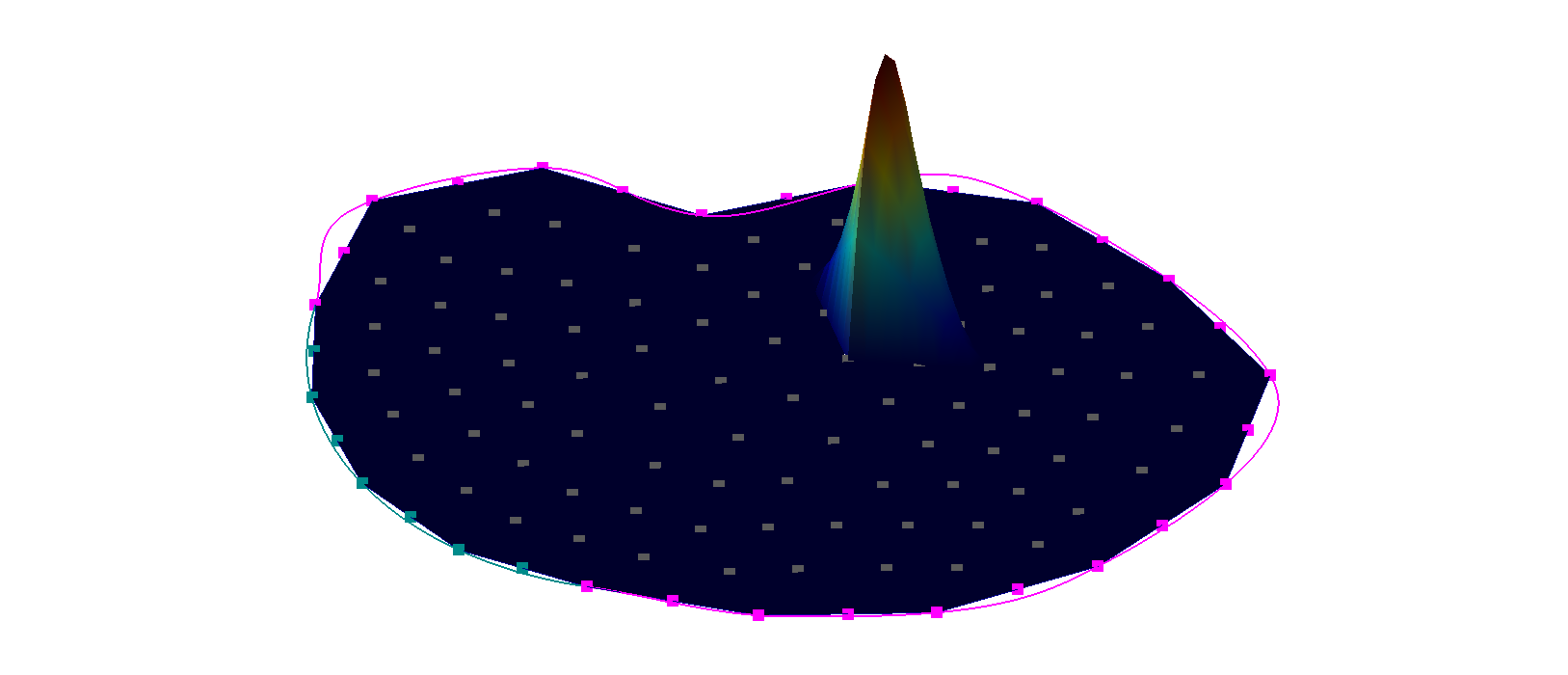

El caso bidimensional en realidad es un problema en tres dimensiones pero sin dependencia de los parámetros del problema en una de las variables espaciales, digamos z. De esta manera, el dominio U \in \mathbb{R}^2 de la geometría está definido sólo sobre el plano x-y y las direcciones de vuelo \hat{\mathbf{\Omega}} de los neutrones son simétricas con respecto a este plano ya que por cada dirección \hat{\mathbf{\Omega}}= [\hat{\Omega}_x \, \hat{\Omega}_y \, \hat{\Omega}_z] con \hat{\Omega}_z>0 hay una dirección simétrica \hat{\mathbf{\Omega}}^\prime= [\hat{\Omega}_x \, \hat{\Omega}_y \, -\hat{\Omega}_z] (figura 3.4). Luego, las posibles direcciones se reducen a la mitad, es decir N(N+2)/2.

Como la derivada espacial del flujo angular con respecto a z es cero entonces por un lado podemos escribir el término de transporte en la ecuación 3.16 como

\hat{\Omega}_{mx} \cdot \frac{\partial{\psi_{mg}}(x,y)}{\partial x} + \hat{\Omega}_{my} \cdot \frac{\partial{\psi_{mg}(x,y)}}{\partial y} donde ahora m=1,\dots,M = N(N+2)/2. La componente {\Omega}_{mz} no aparece explícitamente en las ecuaciones pero sí lo hace implícitamente en la elección de las direcciones, ya que sigue siendo válida la discusión de la sección anterior. Esto implica que en cada cuadrante tenemos nuevamente N(N+2)/8 direcciones posibles, que luego debemos rotar para obtener las M direcciones en los cuatro cuadrantes. Dado que por un lado los pesos deben estar normalizados a uno y por otro para cada dirección con \hat{\Omega}_z>0 hay otra dirección simétrica con \hat{\Omega}_z<0, entonces el conjunto de cuadraturas de nivel simétrico para el primer cuadrante de un dominio de dos dimensiones consiste en las mismas N(N+2)/8 direcciones correspondientes a tres dimensiones.

3.3.1.2 Una dimensión

El caso unidimensional es radicalmente diferente a los otros dos. Si tomamos al eje x como la dirección de dependencia espacial, las posibles direcciones de viaje pueden depender sólo del ángulo cenital \theta ya que la simetría implica que todas las posibles direcciones azimutales con respecto al eje x son igualmente posibles.

El término de transporte es ahora entonces

\hat{\Omega}_{mx} \cdot \frac{\partial{\psi_{mg}}(x)}{\partial x}

El hecho de que no una sino dos componentes de \hat{\mathbf{\Omega}} no aparezcan explícitamente relaja mucho más las condiciones para la elección de las M=N direcciones. En efecto, la única condición es simetría completa entre el semieje x>0 y el semieje x<0, lo que nos deja con N/2 direcciones en cada semieje, todas ellas libres e independientes.

Para seleccionar las N/2 direcciones y sus pesos asociados, notamos que en una dimensión

\int_{4\pi} f(\hat{\mathbf{\Omega}}) \, d\hat{\mathbf{\Omega}}= 2\pi \int_{-1}^{1} f(\hat{\Omega}_x) \, d\hat{\Omega}_x \simeq 2\pi \sum_{m=1}^N w_m \cdot f_m = 4\pi \sum_{m=1}^N \frac{w_m}{2} \cdot f_m = 4\pi \sum_{m=1}^N w_m \cdot f_m \tag{3.21}

Si los puntos \hat{\Omega}_{xm} y los pesos w_m=2\cdot w_m son los asociados a la integración de Gauss y f(\hat{\Omega}_x) es un polinomio de orden 2N-1 o menos, entonces la integración es exacta. En la tabla tabla 3.2 mostramos el conjunto de cuadraturas utilizadas para una dimensión, que contiene esencialmente las abscisas y los pesos de la cuadratura de Gauss.

| m | \hat{\Omega}_{mx} | 2 \cdot w_m | |

|---|---|---|---|

| S_2 | 1 | \sqrt{\frac{1}{3}} | 1 |

| S_4 | 1 | \sqrt{\frac{3}{7}-\frac{2}{7}\sqrt{\frac{6}{5}}} | 0.6521451549 |

| 2 | \sqrt{\frac{3}{7}+\frac{2}{7}\sqrt{\frac{6}{5}}} | 0.3478548451 | |

| S_6 | 1 | 0.2386191860 | 0.4679139346 |

| 2 | 0.6612093864 | 0.3607615730 | |

| 3 | 0.9324695142 | 0.1713244924 | |

| S_8 | 1 | 0.1834346424 | 0.3626837834 |

| 2 | 0.5255324099 | 0.5255324099 | |

| 3 | 0.7966664774 | 0.2223810344 | |

| 4 | 0.9602898564 | 0.1012285363 |

Tabla 3.2: Conjuntos de cuadratura para problemas unidimensionales. Las direcciones \hat{\Omega}_{mx} coinciden con las abscisas de la cuadratura de Gauss. Los pesos w_m de ordenadas discretas son la mitad de los pesos w_m de la cuadratura de Gauss. Las direcciones m=N/2+1,\dots,N no se muestran pero se obtienen como \hat{\Omega}_{N/2+m \, x} = -\hat{\Omega}_{mx} y w_{N/2+m} = w_m.

3.4 Discretización en espacio

Hasta el momento, tenemos por un lado las G ecuaciones de difusión multigrupo

\tag{\ref{eq-difusionmultigrupo}} \begin{gathered} - \text{div} \Big[ D_g(\mathbf{x}) \cdot \text{grad} \left[ \phi_g(\mathbf{x}) \right] \Big] + \Sigma_{t g}(\mathbf{x}) \cdot \phi_g(\mathbf{x}) = \\ \sum_{g^\prime = 1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x}) + \chi_g \sum_{g^\prime = 1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \cdot \phi_{g^\prime}(\mathbf{x})+ s_{0g}(\mathbf{x}) \end{gathered} y las MG ecuaciones de transporte S_N multigrupo

\tag{\ref{eq-transporte-sn}} \begin{gathered} \hat{\mathbf{\Omega}}_m \cdot \text{grad} \left[ \psi_{mg}(\mathbf{x}) \right] + \Sigma_{t g}(\mathbf{x}) \cdot \psi_{mg}(\mathbf{x}) = \sum_{g^\prime=1}^G \Sigma_{s_0 g^\prime \rightarrow g}(\mathbf{x}) \sum_{m^\prime=1} w_{m^\prime} \psi_{m^\prime g^\prime}(\mathbf{x}) + \\ 3 \sum_{g^\prime=1}^G \Sigma_{s_1 g^\prime \rightarrow g}(\mathbf{x}) \sum_{m^\prime=1} w_{m^\prime} \left( \hat{\mathbf{\Omega}}_{m} \cdot \hat{\mathbf{\Omega}}_{m^\prime} \right) \psi_{m^\prime g^\prime}(\mathbf{x}) + \chi_g \sum_{g^\prime=1}^G \nu\Sigma_{fg^\prime}(\mathbf{x}) \sum_{m^\prime=1} w_{m^\prime} \psi_{m^\prime g^\prime}(\mathbf{x}) + s_{mg}(\mathbf{x}) \end{gathered} en las que las incógnitas \phi_g y \psi_{mg} dependen solamente del espacio \mathbf{x}. En esta sección empleamos el método de elementos finitos [16] para discretizar la variable independiente espacial y obtener finalmente un sistema de ecuaciones algebraicas que nos permita resolver neutrónica a nivel de núcleo en forma numérica con una (o más) computadora(s) digital(es).

Existe una gran cantidad de teoría matemática detrás del método de elementos finitos para resolver ecuaciones diferenciales a partir de formulaciones débiles o variacionales. Esencialmente el grueso de la literatura teórica [3], [8], [11] se centra en probar

- que la formulación débil (definición 3.13) de una ecuación diferencial es formalmente correcta con respecto a derivabilidad e integrabilidad en el sentido de distribuciones sobre espacios de Hilbert,

- que soluciones continuas pero no necesariamente diferenciables en a lo más un sub-espacio de medida cero tienen sentido matemático, y

- que el esquema numérico es consistente (definición 3.2), estable (definición 3.3) y convergente (definición 3.1).

De la misma manera que el capítulo 2, esencialmente repetimos teoría matemática ya conocida a partir de diferentes fuente pero “digerida” a lo Séneca de forma tal de unificar nomenclaturas y criterios, en este hacemos lo mismo por cuestiones de consistencia. Mostramos algunos resultados conocidos y derivamos con algún cierto nivel de detalle razonable (teniendo en cuenta que es ésta una tesis de Ingeniería y no de Matemática) el problema de aproximación de Galerkin a partir de la formulación débil de un problema en derivadas parciales. Dejamos la derivación completa incluyendo la teoría de análisis funcional necesaria para demostrar completamente todos los resultados del método de elementos finitos en las referencias [3], [7], [11]. En la monografía [15] escrita durante el plan de formación de este doctorado se muestra una derivación de la formulación en elementos finitos de la ecuación de difusión multigrupo de forma menos formal pero más intuitiva. Incluso se comparan los resultados numéricos obtenidos con dicha formulación con los obtenidos con una formulación basada en volúmenes finitos [4].

Proposición 3.1 Si se pudiera intercambiar en toda la literatura existente (y en las clases, seminarios, conferencias, etc.) la palabra “elementos” por “volúmenes” (¿tal vez con sed siguiendo la filosofía del Apéndice C?) nadie notaría la diferencia. Ver la referencia [10] y sus doscientas ochenta referencias para la historia detrás del “método de elementos finitos”.

Comenzamos ilustrando la aplicación el método de elementos finitos a un operador elíptico escalar, en particular a la ecuación de Poisson generalizada.13 Para este caso introducimos las ideas básicas de

- la formulación débil o variacional (Sección 3.4.1),

- la aproximación de Galerkin (Sección 3.4.1.4), y

- la discretización por elementos finitos (Sección 3.4.1.5).

Luego en la Sección 3.4.2 aplicamos estas ideas para obtener las versiones completamente discretizadas de las ecuaciones de difusión multigrupo, que también son elípticas pero el problema deja de ser un escalar en cada nodo espacial y su operador no es simétrico para G>1. Finalmente en la Sección 3.4.3 hacemos lo mismo para transporte por S_N multigrupo. En este caso la incógnita también tiene varios grados de libertad en cada nodo espacial. Pero además el operador es parabólico de primer orden y la formulación numérica requiere de un término de estabilización.

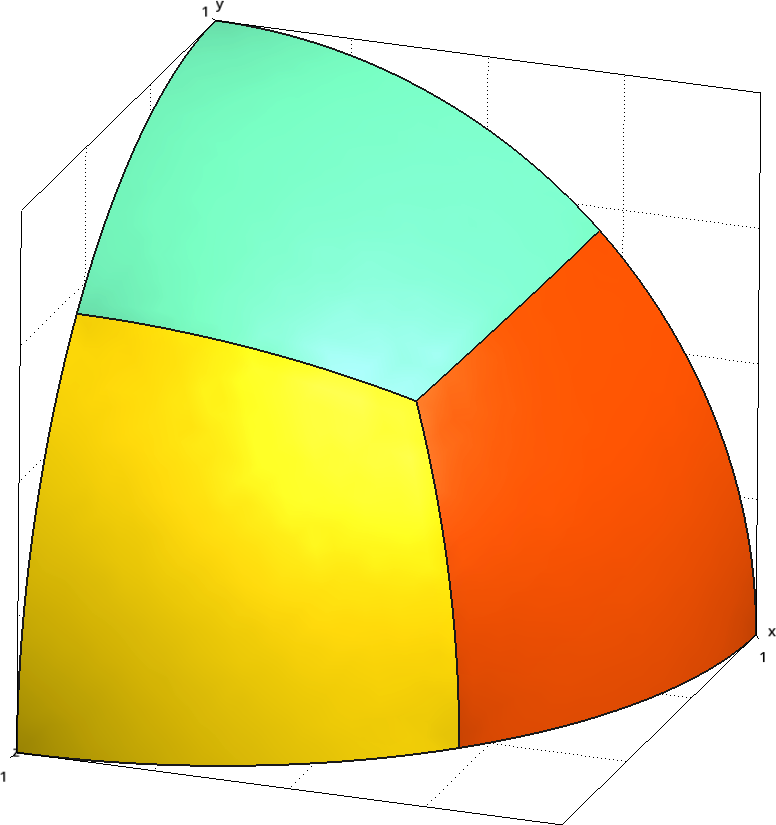

3.4.1 Ecuación de Poisson generalizada

Comencemos resolviendo la ecuación escalar elíptica de Poisson generalizada (en el sentido de que el coeficiente del operador diferencial puede depender del espacio) sobre un dominio espacial D-dimensional U \in \mathbb{R}^D—cuya frontera es \partial U—con condiciones de contorno de Dirichlet homogéneas en \Gamma_D \in \partial U y condiciones arbitrarias de Neumann en \Gamma_N \in \partial U tal que \Gamma_D \cup \Gamma_N = \partial U y \Gamma_D \cap \Gamma_N = \emptyset (figura 3.6):

\begin{cases} -\text{div} \Big[ k(\mathbf{x}) \cdot \text{grad} \left[ u(\mathbf{x}) \right] \Big] = f(\mathbf{x}) & \forall\mathbf{x} \in U \\ u(\mathbf{x}) = 0 & \forall \mathbf{x} \in \Gamma_D \\ k(\mathbf{x}) \cdot \Big[ \text{grad} \left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big] = p(\mathbf{x}) & \forall \mathbf{x} \in \Gamma_N \end{cases} \tag{3.22} donde \hat{\mathbf{n}} es la normal externa a la frontera \partial U en el punto \mathbf{x}.

3.4.1.1 Formulaciones fuertes y débiles

Definición 3.12 (formulación fuerte) Llamamos a la ecuación diferencial propiamente dicha junto con sus condiciones de contorno, tal como las escribimos en la ecuación 3.22, la formulación fuerte del problema.

Observación. En la formulación fuerte, todas las funciones deben ser derivables al menos hasta el orden apropiado según dónde aparezca cada una. Por ejemplo, en la ecuación 3.22, tanto u como el producto k \nabla u deben ser derivables. Este requerimiento usualmente es demasiado restrictivo en aplicaciones físicas. Por ejemplo, la formulación fuerte del problema de conducción de calor no está bien definida en las interfaces entre materiales con diferentes conductividades k a cada lado de la interfaz.

Multipliquemos ambos miembros de la ecuación diferencial por una cierta función v(\mathbf{x}) que llamamos “de prueba”:14

-v(\mathbf{x}) \cdot \text{div} \Big[ k(\mathbf{x}) \cdot \text{grad} \left[ u(\mathbf{x}) \right] \Big] = v(\mathbf{x}) \cdot f(\mathbf{x}) \tag{3.23}

Esta función de prueba v(\mathbf{x}) puede ser (en principio) arbitraria, pero requerimos que se anule en \Gamma_D. Es decir, por ahora pedimos que u(\mathbf{x}) y v(\mathbf{x}) satisfagan las mismas condiciones de contorno de Dirichlet homogéneas (aunque no necesariamente las de Neumann).

Teorema 3.4 (de la divergencia) En un dominio conexo U \in \mathbb{R}^D, la integral de volumen sobre U de la divergencia de una función vectorial continua \mathbf{F}(\mathbf{x}) : U \mapsto \mathbb{R}^D es igual a la integral de superficie del producto interno entre \mathbf{F} y la normal externa \hat{\mathbf{n}} a la frontera \partial U:

\int_U \mathrm{div} \left[ \mathbf{F}(\mathbf{x}) \right] \, d^D\mathbf{x} = \int_{\partial U} \mathbf{F}(\mathbf{x}) \cdot \hat{\mathbf{n}} \, d^{D-1}\mathbf{x}

Prueba. Cualquier libro de Análisis II.

Corolario 3.5 (fórmula de Green) En un dominio conexo U \in \mathbb{R}^D, sean u(\mathbf{x}), v(\mathbf{x}) y k(\mathbf{x}) funciones continuas U \mapsto \mathbb{R}. Entonces

\begin{aligned} \int_U v(\mathbf{x}) \cdot \mathrm{div} \Big[ k(\mathbf{x}) \cdot \mathrm{grad} \left[ u(\mathbf{x}) \right] \Big] \,d^D\mathbf{x} =& -\int_U \mathrm{grad} \left[ v(\mathbf{x}) \right] \cdot k(\mathbf{x}) \cdot \mathrm{grad} \left[ u(\mathbf{x}) \right] \, d^D\mathbf{x} \\ & \quad\quad + \int_{\partial U} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \mathrm{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x} \end{aligned} siendo \hat{\mathbf{n}} la normal exterior a la frontera \partial U en el punto \mathbf{x}.

Prueba. Recordando el teorema 2.9 de la generalización de la derivada de un producto que dice que

\text{div} \big[ a \cdot \mathbf{b} \big ] = a \cdot \text{div} \left[\mathbf{b}\right] + \mathbf{b} \cdot \text{grad}\left[a\right] entonces para a = v y \mathbf{b} = k \nabla u

\text{div} \Big[ v(\mathbf{x}) \cdot k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] \Big] = v(\mathbf{x}) \cdot \text{div}\Big[ k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] \Big] + k(\mathbf{x}) \cdot \text{grad}\left[u(\mathbf{x})\right] \cdot \text{grad}\left[v(\mathbf{x})\right]

Integrando sobre el volumen U15

\begin{aligned} \int_U \text{div} \Big[ v(\mathbf{x}) \cdot k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] \Big] \, d^D\mathbf{x} =& \int_U v(\mathbf{x}) \cdot \text{div}\Big[ k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] \Big] \, d^D\mathbf{x} \\ &\quad + \int_U k(\mathbf{x}) \cdot \text{grad}\left[u(\mathbf{x})\right] \cdot \text{grad}\left[v(\mathbf{x})\right] \, d^D\mathbf{x} \end{aligned}

Haciendo \mathbf{F}(\mathbf{x}) = v(\mathbf{x}) \cdot k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] en el teorema 3.4 tenemos

\int_U \text{div} \Big[ v(\mathbf{x}) \cdot k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] \Big] \, d^D\mathbf{x} = \int_{\partial U} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \text{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x}

Igualando los miembros derechos de las últimas dos expresiones

\begin{aligned} \int_{\partial U} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \text{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x} =& \int_U v(\mathbf{x}) \cdot \text{div}\Big[ k(\mathbf{x}) \cdot \text{grad}\left[ u(\mathbf{x})\right] \Big] \, d^D\mathbf{x} \\ &\quad + \int_U k(\mathbf{x}) \cdot \text{grad}\left[u(\mathbf{x})\right] \cdot \text{grad}\left[v(\mathbf{x})\right] \, d^D\mathbf{x} \end{aligned}

Reordenando los términos, llegamos a la tesis del teorema.

Como \Gamma_D \cup \Gamma_N = \partial U y \Gamma_D \cap \Gamma_N = \emptyset, entonces podemos escribir la integral de superficie sobre la frontera \partial U como suma de dos integrales con el mismo integrando, una sobre \Gamma_D y otra sobre \Gamma_N:

\begin{aligned} \int_{\partial U} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \mathrm{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x} =& \int_{\Gamma_D} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \mathrm{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x} \\ &\quad + \int_{\Gamma_N} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \mathrm{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x} \end{aligned}

Pero

habíamos pedido que v(\mathbf{x}) se anule en \Gamma_D

v(\mathbf{x}) = 0 \quad \forall \mathbf{x} \in \Gamma_D

la condición de contorno de Neumann indica que

k(\mathbf{x}) \cdot \Big[ \text{grad} \left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big] = p(\mathbf{x}) \quad \forall \mathbf{x} \in \Gamma_N

por lo que

\int_{\partial U} v(\mathbf{x}) \cdot \left[ k(\mathbf{x}) \cdot \Big( \mathrm{grad}\left[ u(\mathbf{x}) \right] \cdot \hat{\mathbf{n}} \Big) \right] \, d^{D-1}\mathbf{x} = \int_{\Gamma_N} v(\mathbf{x}) \cdot p(\mathbf{x}) \,d^{D-1}\mathbf{x}

Volvamos a la ecuación 3.23 e integremos ambos miembros sobre el dominio U

-\int_U v(\mathbf{x}) \cdot \text{div} \Big[ k(\mathbf{x}) \cdot \text{grad} \left[ u(\mathbf{x}) \right] \Big] \,d^D\mathbf{x} = \int_U v(\mathbf{x}) \cdot f(\mathbf{x}) \,d^D\mathbf{x}

Ahora usemos la fórmula de Green y el hecho de que v(\mathbf{x}) se anula en \Gamma_D para obtener

\int_U \text{grad} \left[ v(\mathbf{x}) \right] \cdot k(\mathbf{x}) \cdot \text{grad} \left[ u(\mathbf{x}) \right] \,d^D\mathbf{x} = \int_U v(\mathbf{x}) \cdot f(\mathbf{x}) \,d^D\mathbf{x} + \int_{\Gamma_N} p(\mathbf{x}) \cdot v(\mathbf{x}) \,d^{D-1}\mathbf{x} \tag{3.24}

Definición 3.13 (formulación débil) Llamamos a la expresión que resulta de

- multiplicar ambos miembros de la ecuación diferencial por una función arbitraria llamada “de prueba” que se anula en \Gamma_D,

- integrar sobre el dominio espacial,

- aplicar fórmulas de cálculo vectorial, y

- reemplazar la condición de contorno de Neumann en las integrales de superficie

tal como la ecuación 3.24, junto con los requerimientos que deben satisfacer tanto la función incógnita como la función de prueba, la formulación débil o variacional del problema. Estrictamente hablando, la formulación débil de una ecuación diferencial es

\text{encontrar~} u(\mathbf{x}) \in V: \quad \mathcal{a} \Big(u(\mathbf{x}), v(\mathbf{x})\Big) = \mathcal{B} \Big(v(\mathbf{x})\Big) \quad \forall v(\mathbf{x}) \in V donde V es un espacio funcional apropiado, por ejemplo el H^1_0(U) de las funciones U \in \mathbb{R}^D \mapsto \mathbb{R} cuyo gradiente (el superíndice uno) es de cuadrado integrable en el dominio U y que se anulan en \Gamma_D (el subíndice cero)

V = H^1_0 (U) = \left\{ v \in H^1_0 (U) : \int_U \left( \nabla v \right)^{2} \,d^D\mathbf{x} < \infty \wedge v(\mathbf{x}) = 0 \forall \mathbf{x} \in \Gamma_D \right\} y los operadores \mathcal{a}(u,v) : V \times V \mapsto \mathbb{R} y \mathcal{B}(v) : V \mapsto \mathbb{R} se obtienen a partir de los cuatro pasos arriba mencionados. En particular, para el problema generalizado de Poisson de la formulación de la ecuación 3.24, es

\begin{aligned} \mathcal{a}(u,v) &= \int_U \text{grad}\Big[ v(\mathbf{x}) \Big] \cdot k(\mathbf{x}) \cdot \text{grad}\Big[ u(\mathbf{x}) \Big] \, d^D \mathbf{x} \\ \mathcal{B}(v) &= \int_U v(\mathbf{x}) \cdot f(\mathbf{x}) \, d^D \mathbf{x} + \int_{\Gamma_N} v(\mathbf{x}) \cdot p(\mathbf{x}) \, d^{D-1} \mathbf{x} \end{aligned} \tag{3.25}

Observación. En la formulación débil la derivabilidad es más laxa que en la formulación fuerte. De ahí su nombre: las funciones deben cumplir requerimientos más débiles. Por un lado, al involucrar una operación de integración sobre el dominio y aplicar fórmulas de Green, los requerimientos de derivabilidad disminuyen un grado: en la formulación fuerte 3.22, u tiene que ser derivable dos veces ya que el operador es esencialmente el laplaciano mientras que en la formulación débil 3.24 sólo involucra el gradiente. De hecho, ni siquiera hace falta que las funciones sean tan derivables según en el lugar dónde aparecen en la formulación ya que las las integrales deben tomarse según el sentido de Lebesgue y no según el sentido de como Riemann: todas las funciones dentro de las integrales pueden ser discontinuas en un sub-espacio de medida nula. En efecto, la formulación débil del problema de conducción de calor con conductividad discontinua en interfaces materiales está bien definida. Por un lado las interfaces materiales son un sub-espacio de medida nula y por otro la conductividad k(\mathbf{x}) no tiene aplicado ningún operador diferencial sino que es integrado (en el sentido de Lebesgue) sobre el dominio espacial U.

Observación. La formulación débil de la ecuación de conducción de calor derivada en la ecuación 3.24 incluye la posibilidad de que la conductividad k(\mathbf{x}) pueda depender del espacio e incluso ser discontinua en interfaces materiales. Más aún, la derivación propuesta puede ser extendida para el caso no lineal en el cual la conductividad pueda depender de la incógnita k(u). Ver por ejemplo el problema de conducción de calor no lineal del Sección B.3.1.3.

Observación. El nombre variacional viene del hecho de requerir que \mathcal{a}(u,v) = \mathcal{B}(v) para todas las posibles funciones de prueba v(\mathbf{x}) \in V. Es decir, de requerir que v pueda “variar” arbitrariamente (siempre que se anule en \Gamma_D) y la igualdad se siga manteniendo.

Observación. La formulación fuerte incluye las condiciones de contorno en su enunciado. Las condiciones de Neumann aparecen naturalmente en los términos de superficie luego de aplicar las fórmulas de Green y las condiciones de Dirichlet están esencialmente en el espacio vectorial V donde se busca la solución u. Las primeras se llaman naturales y las segundas esenciales.

Teorema 3.5 El problema débil es equivalente al fuerte en el sentido de distribuciones, es decir, ambas formulaciones coinciden excepto en a lo más un sub-conjunto de U de medida cero.

Definición 3.14 (funcional lineal) Un funcional \mathcal{B}(v) : V \mapsto \mathbb{R} es lineal si

\mathcal{B}(\alpha \cdot v_1 + \beta \cdot v_2) = \alpha \cdot \mathcal{B}(v_1) + \beta \cdot \mathcal{B}(v_2)

Definición 3.15 (operador bi-lineal) Un operador \mathcal{a}(v,u) : V \times V \mapsto \mathbb{R} es bi-lineal si

\mathcal{a}(\alpha \cdot v_1 + \beta \cdot v_2, u) = \alpha \cdot \mathcal{a}(v_1,u) + \beta \cdot \mathcal{a}(v_2,u) y \mathcal{a}(v, \alpha \cdot u_1 + \beta \cdot u_2) = \alpha \cdot \mathcal{a}(v,u_1) + \beta \cdot \mathcal{a}(v,u_2)

Definición 3.16 (operador simétrico) Un operador \mathcal{a}(v,u) es simétrico si

\mathcal{a}(v,u) = \mathcal{a}(u,v)

Definición 3.17 (operador coercitivo) Un operador \mathcal{a}(v,u) : V \times V \mapsto \mathbb{R} es coercitivo si existe una constante \alpha >0 tal que

\mathcal{a}(v,v) \geq \alpha \cdot || v ||^2_V

Corolario 3.6 Si \mathcal{a}(v,u) es coercitivo entonces

||v||_{\mathcal{a}} = \sqrt{\mathcal{a}(v,v)} es una norma.

Teorema 3.6 El operador

\mathcal{a}(u,v) = \int_U \mathrm{grad}\Big[ v(\mathbf{x}) \Big] \cdot k(\mathbf{x}) \cdot \mathrm{grad}\Big[ u(\mathbf{x}) \Big] \, d^D \mathbf{x} es coercitivo si k(\mathbf{x}) > 0 \forall \mathbf{x} \in U.

Prueba. La demostración detallada se puede encontrar la sección 5.3 de [3] e en involucra análisis funcional y algunas desigualdades, como la de Poincaré. La idea básica es que \int_U [\nabla v]^2 d^D\mathbf{x} se comporta en forma similar a \int_U v^2 d^D\mathbf{x}.

Teorema 3.7 (de Lax-Milgram) Dada una formulación débil

\text{encontrar~} u \in V: \quad \mathcal{a} (u, v) = \mathcal{B} (v) \quad \forall v \in V siendo

- V un sub-espacio de H^1(U),

- \mathcal{a} : V \times V \mapsto \mathbb{R} un operador continuo, bi-lineal y coercitivo, y

- \mathcal{B} : V \mapsto \mathbb{R} un funcional continuo y lineal

entonces la solución u existe y es única.