4 Implementación computacional

C++ is a horrible language. It’s made more horrible by the fact that a lot of substandard programmers use it, to the point where it’s much much easier to generate total and utter crap with it. Quite frankly, even if the choice of C were to do nothing but keep the C++ programmers out, that in itself would be a huge reason to use C.

[…]

C++ leads to really really bad design choices. You invariably start using the “nice” library features of the language like STL and Boost and other total and utter crap, that may “help” you program, but causes:

infinite amounts of pain when they don’t work […]

inefficient abstracted programming models where two years down the road you notice that some abstraction wasn’t very efficient, but now all your code depends on all the nice object models around it, and you cannot fix it without rewriting your app.

[…]

So I’m sorry, but for something like git, where efficiency was a primary objective, the “advantages” of C++ is just a huge mistake. The fact that we also piss off people who cannot see that is just a big additional advantage.

Linus Torvalds, explaining why Git is written in C, 2007

C++ is a badly designed and ugly language.

It would be a shame to use it in Emacs.Richard M. Stallmann, explaining why Emacs is written in C, 2010

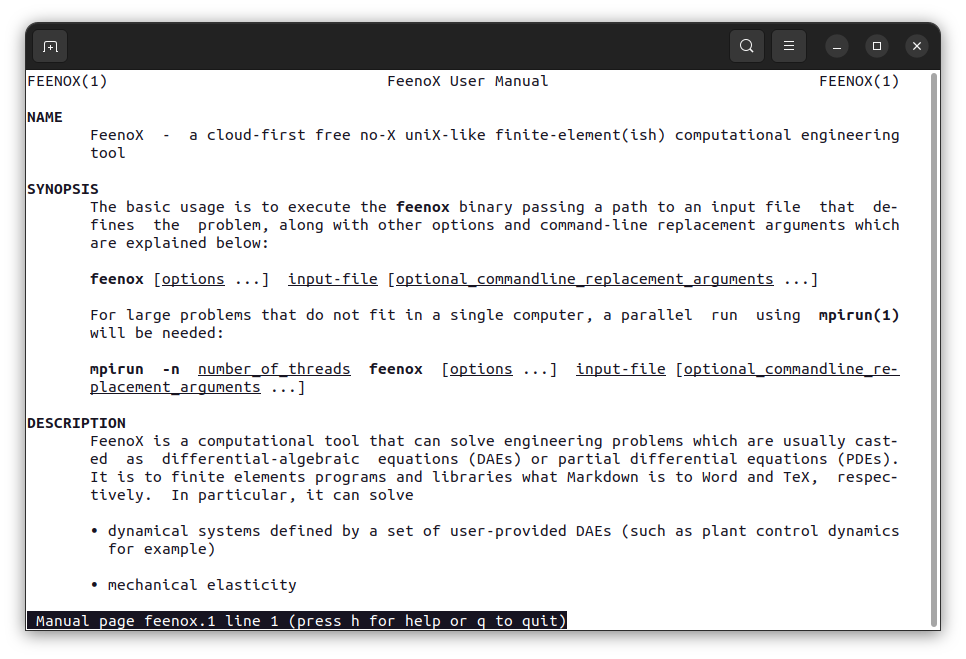

Hay virtualmente infinitas maneras \aleph_0 de diseñar un programa para que una computadora realice una determinada tarea. Y otras infinitas maneras \aleph_1 de implementarlas. La herramienta computacional desarrollada en esta tesis, denominada FeenoX [26] (ver Apéndice E para una explicación del nombre), fue diseñada siguiendo un patrón frecuente en la industria de software:

- el “cliente” define un documento denominado Sofware Requirements Specification, y

- el “proveedor” indica cómo cumplirá esos requerimientos en un Sofware Design Specification.

Una vez que ambas partes están de acuerdo, se comienza con el proyecto de ingeniería en sí con kick-off meetings, certificaciones de avance, órdenes de cambio, etc.

Como ya hemos mencionado, el SRS para FeenoX (apéndice A) es ficticio pero plausible. Podríamos pensarlo como un llamado a licitación por parte de una empresa, entidad pública o laboratorio nacional, para que un contratista desarrolle una herramienta computacional que permita resolver problemas matemáticos con interés práctico en aplicaciones de ingeniería. En forma muy resumida, el pliego requiere

buenas prácticas generales de desarrollo de software tales como

- trazabilidad del código fuente

- integración continua

- posibilidad de reportar errores

- portabilidad razonable

- disponibilidad de dependencias adecuadas

- documentación apropiada

que la herramienta pueda ser ejecutada en la nube

- a través de ejecución remota

- que provea mecanismos de reporte de estado

- con posibilidad de paralelización en diferentes nodos computacionales

que sea aplicable a problemas de ingeniería proveyendo

- eficiencia computacional razonable

- flexibilidad en la definición de problemas

- verificación y validación

- extensibilidad

Observación. El requerimiento de paralelización está relacionado con el tamaño de los problemas a resolver y no (tanto) con la performance. Está claro que, de tener la posibilidad, resolver ecuaciones en forma paralela es más eficiente en términos del tiempo de pared1 necesario para obtener un resultado. Pero en el SRS, la posibilidad de paralelizar el código se refiere principalmente a la capacidad de poder resolver problemas de tamaño arbitrario que no podrían ser resueltos en serie, principalmente por una limitación de la cantidad de memoria RAM.

Observación. Si bien es cierto que en teoría un algoritmo implementado en cualquier lenguaje Turing-completo podría resolver un sistema de ecuaciones algebraicas de tamaño arbitrario independientemente de la memoria RAM disponible (por ejemplo usando almacenamiento intermedio en dispositivos magnéticos o de estado sólido), no es posible obtener un resultado útil en un tiempo razonable si no se dispone de suficiente memoria RAM para evitar tener que descargar el contenido de esta memoria de alta velocidad de acceso a medios alternativos (out-of-core memory como los mencionados en el paréntesis anterior) cuya velocidad de acceso es varios órdenes de magnitud más lenta.

Observación. Este esquema de definir primero los requerimientos y luego indicar cómo se los satisface evita un sesgo común dentro de las empresas de software que implica hacer algo “fácil para el desarrollador” a costa de que el usuario tenga que hacer algo “más difícil”. Por ejemplo en la mayoría de los programas de elementos finitos para elasticidad lineal es necesario hacer un mapeo entre los grupos de elementos volumétricos y los materiales disponibles, tarea que tiene sentido siempre que haya más de un grupo de elementos volumétricos o más de un material disponible. Pero en los casos donde hay un único grupo de elementos volumétricos (usualmente porque se parte de un CAD con un único volumen) y un único juego de propiedades materiales (digamos un único valor E de módulo de Young y un único \nu para coeficiente de Poisson), el software requiere que el usuario tenga que hacer explícitamente el mapeo aún cuando éste sea único y trivial. Un claro de ejemplo del sesgo “developer-easy/user-hard” que FeenoX no tiene2, ya que el SRS pide que “problemas sencillos tengan inputs sencillos”. En caso de que haya una única manera de asociar volúmenes geométricos a propiedades materiales, FeenoX hace la asociación implícitamente simplificando el archivo de entrada.

Según el pliego, es mandatorio que el software desarrollado sea de código abierto según la definición de la Open Source Initiative. El SDS (apéndice B) comienza indicando que la herramienta FeenoX es

- al software tradicional de ingeniería y

- a las bibliotecas especializadas de elementos finitos

lo que Markdown es

- a Word y

- a LaTeX

respectivamente.

Luego explica que no sólo es de código abierto en el sentido de la OSI sino que también es libre en el sentido de la Free Software Foundation [30], como pide el SRS. La diferencia entre código abierto y software libre es más sutil que práctica, ya que las definiciones técnicas prácticamente coinciden. El punto principal de que el código sea abierto es que permite obtener mejores resultados con mejor performance mientras más personas puedan estudiar el código, escrutarlo y eventualmente mejorarlo [12]. Por otro lado, el software libre persigue un fin ético relacionado con la libertad de poder ejecutar, distribuir, modificar y distribuir las modificaciones del software recibido [17], [28]. En la Sección 4.4.1 discutimos los detalles de estas ideas.

Observación. Ninguno de los dos conceptos, código abierto o software libre, se refiere a la idea de precio. En castellano no debería haber ninguna confusión. Pero en inglés, el sustantivo adjetivado free software se suele tomar como gratis en lugar de libre. Si bien es cierto que la mayoría de las veces la utilización de software libre y abierto no implica el pago de ninguna tarifa directa al autor del programa, el software libre puede tener otros costos indirectos asociados.3 El concepto importante es libertad: la libertad de poder contratar a uno o más programadores que modifiquen el código para que el software se comporte como uno necesita.

Tal como como Unix4 [14] y C5, FeenoX es un “efecto de tercer sistema”6 [13]. De hecho, esta diferencia entre el concepto de código abierto y software libre fue discutida en la referencia [21] durante el desarrollo de la segunda versión del sistema. Una vez más, la Sección 4.4.1 provee una explicación de los conceptos fundamentales y, literalmente, de la filosofía detrás de la idea de software libre.

De las lecciones aprendidas en las dos primeras versiones, la primera un poco naíf pero funcional y la segunda más pretenciosa y compleja (apalancada en la funcionalidad de la primera), hemos convergido al diseño explicado en el SDS del apéndice B donde definimos la filosofía de diseño del software y elegimos una de estas infinitas formas de diseñar una herramienta computacional mencionadas al comienzo de este capítulo. Gran parte de este diseño está basado en la filosofía de programación Unix [13]. En el apéndice B damos ejemplos de cómo son las interfaces para definir un cierto problema y de cómo obtener los resultados. Comparamos alternativas e indicamos por qué hemos decidido diseñar el software de la forma en la que lo hemos hecho y comentamos muy superficialmente las ideas distintivas que tiene FeenoX con respecto a otros programas de elementos finitos desde el punto de vista técnico de programación. Estas características son distintivas del diseño e implementación propuestos y no son comunes. En la jerga de emprendedurismo, serían las unfair advantages del software con respecto a otras herramientas similares.

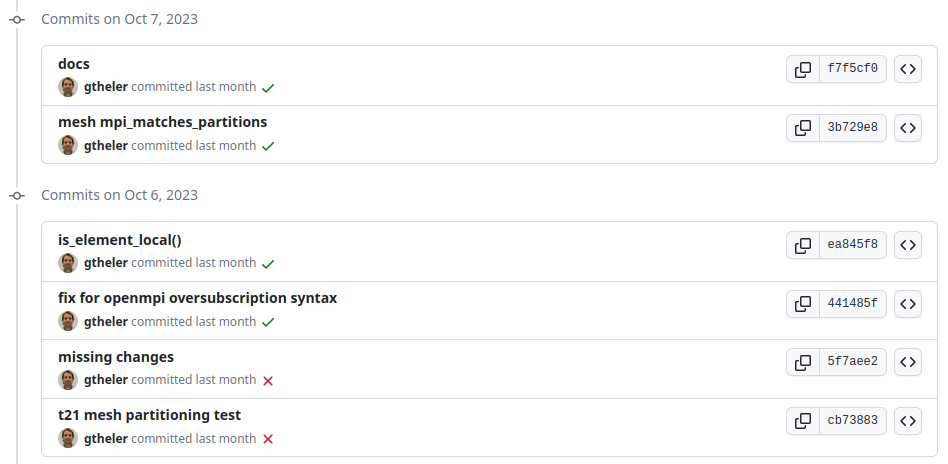

Observación. El código fuente de FeenoX está en Github en https://github.com/seamplex/feenox/ bajo licencia GPLv3+ (Sección 4.4.1). Consiste en aproximadamente cuarenta y cinco mil líneas de código .·

Observación. El Journal of Open Source Software ha publicado un artículo donde sucintamente se presentan las características distintivas de FeenoX con respecto a otras herramientas libres y abiertas ya existentes [26]. Tanto dicho artículo como esta tesis corresponden a la versión 1.0 del software, que a su vez corresponde al tag v1.0 del repositorio en Github.

4.1 Arquitectura del código

Comencemos preguntándonos qué debemos tener en cuenta para implementar una herramienta computacional que permita resolver ecuaciones en derivadas parciales con aplicación en ingeniería utilizando el método de elementos finitos. Por el momento enfoquémonos en problemas lineales7 como los analizados en los dos capítulos anteriores. Las dos tareas principales son

- construir la matriz global de rigidez \mathsf{K} y el vector \mathbf{b} (o la matriz de masa \mathsf{M}), y

- resolver el sistema de ecuaciones \mathsf{K} \cdot \mathbf{u} = \mathbf{b} (o \mathsf{K} \cdot \mathbf{u} = \lambda \cdot \mathsf{M} \cdot \mathbf{u})

- convertir \mathbf{u} en flujos \psi(\mathbf{x}) y/o \phi(\mathbf{x})

Haciendo énfasis en la filosofía Unix, tenemos que escribir un programa que haga bien una sola cosa8 que nadie más hace y que interactúe con otros que hacen bien otras cosas (regla de composición). En este sentido, nuestra herramienta se tiene que enfocar en los puntos 1 y 3. Pero tenemos que definir quién va a hacer el punto 2 para que sepamos cómo es que tenemos que construir \mathsf{K} y \mathbf{b}.

Las bibliotecas PETSc [3], [4] junto con la extensión SLEPc [7], [15] proveen exactamente lo que necesita una herramienta que satisfaga el SRS siguiendo la filosofía de diseño del SDS. De hecho, en 2010 seleccioné PETSc para la segunda versión del solver neutrónico por la única razón de que era una dependencia necesaria para resolver el problema de criticidad con SLEPc [22], [23]. Con el tiempo, resultó que PETSc proveía el resto de las herramientas necesarias para resolver numéricamente ecuaciones en derivadas parciales en forma portable y extensible.

Otra vez desde el punto de vista de la filosofía de programación Unix, la tarea 1 consiste en un cemento de contacto9 entre la definición del problema a resolver por parte del ingeniero usuario y la biblioteca matemática para resolver problemas ralos10 PETSc [11]. Cabe preguntarnos entonces cuál es el lenguaje de programación adecuado para implementar el diseño del SDS. Aún cuando ya mencionamos que cualquier lenguaje Turing-completo es capaz de resolver un sistema de ecuaciones algebraicas, está claro que no todos son igualmente convenientes. Por ejemplo Assembly o BrainFuck son interesantes en sí mismos (por diferentes razones) pero para nada útiles para la tarea que tenemos que realizar. De la misma manera, en el otro lado de la distancia con respecto al hardware, lenguajes de alto nivel como Python o R también quedan fuera de la discusión por cuestiones de eficiencia computacional. A lo sumo, estos lenguajes interpretados podrían servir para proveer clientes finos11 (ver Sección 4.4.6) a través de APIs12 que puedan llegar a simplificar la definición del (o los) problema(s) que tenga que resolver FeenoX. Para resumir una discusión mucho más compleja, los lenguajes candidatos para implementar la herramienta requerida por el SRS podrían ser

- Fortran

- C

- C++

Según la regla de representación de Unix, la implementación debería poner la complejidad en las estructuras de datos más que en la lógica. Sin embargo, en el área de mecánica computacional, paradigmas de programación demasiado orientados a objetos impactan negativamente en la performance. La tendencia es encontrar un balance, tal como persigue la filosofía desde hace más de dos mil quinientos años a través de la virtud de la prudencia, entre programación orientada a objetos y programación orientada a datos.

Observación. En los últimos años el lenguaje Rust se ha comenzado a posicionar como una alternativa a C para system programming13 debido al requerimiento intrínseco de que todos las referencias deben apuntar a una dirección de memoria virtual válida. A principios de 2023 aparecieron por primera vez líneas de código en Rust en el kernel de Linux. Pero desde el punto de vista de computación de alto rendimiento,14 Rust (o incluso Go) no tienen nada nuevo que aportar con respecto a C.

Tal como explican los autores de PETSc (y coincidentemente Eric Raymond en [13]), C es el lenguaje que mejor se presta a este paradigma:

Why is PETSc written in C, instead of Fortran or C++?

When this decision was made, in the early 1990s, C enabled us to build data structures for storing sparse matrices, solver information, etc. in ways that Fortran simply did not allow. ANSI C was a complete standard that all modern C compilers supported. The language was identical on all machines. C++ was still evolving and compilers on different machines were not identical. Using C function pointers to provide data encapsulation and polymorphism allowed us to get many of the advantages of C++ without using such a large and more complicated language. It would have been natural and reasonable to have coded PETSc in C++; we opted to use C instead.

Fortran fue diseñado en la década de 1950 y en ese momento representó un salto cualitativo con respecto a la forma de programar las incipientes computadoras digitales [9]. Sin embargo, las suposiciones que se han tenido en cuenta con respecto al hardware y a los sistemas operativos sobre los cuales estos programas deberían ejecutarse ya no son válidas. Las revisiones posteriores como Fortran 90 son modificaciones y parches que no resuelven el problema de fondo. En cambio, C fue diseñado a principios de la década 1970 suponiendo arquitecturas de hardware y de sistemas operativos que justamente son las que se emplean hoy en día, tales como

- espacio de direcciones plano15

- procesadores con registros de diferentes tamaños

- llamadas al sistema16

- entrada y salida basada en archivos

- etc.

para correr en entornos Unix, que esencialmente, es el sistema operativo de la vasta mayoría de los servidores de la nube pública, que justa y nuevamente, es lo que perseguimos en esta tesis.

Una vez más, en principio, la misma tarea puede ser implementada en cualquier lenguaje: Fortran podría implementar programación con objetos y C++ podría ser utilizado con un paradigma orientado a datos. Pero lo usual es que código escrito en Fortran sea procedural y basado en estructuras COMMON, resultando difícil de entender y depurar (y mantener y extender). El código escrito en C++ suele ser orientado a objetos y con varias capas de encapsulamiento, polimorfismo, métodos virtuales, re-definición de operadores17 y contenedores enplantillados18 resultando difícil de entender y depurar, tal como indica Linus Torvals en la cita del comienzo del capítulo. De la misma manera que el lenguaje Fortran permite realizar ciertas prácticas que bien utilizadas agregan potencia y eficiencia pero cuyo abuso lleva a código ininteligible (por ejemplo el uso y abuso de bloques COMMON), C++ permite ciertas prácticas que bien utilizadas agregan potencia pero cuyo abuso lleva a código de baja calidad (por ejemplo el uso y abuso de templates, shared_pointers, binds, moves, lambdas, wrappers sobre wrappers, objetos sobre objetos, interfaz sobre interfaz, etc.), a veces en términos de eficiencia, a veces en términos del concepto de Unix compactness [13]:

Compactness is the property that a design can fit inside a human being’s head. A good practical test for compactness is this: Does an experienced user normally need a manual? If not, then the design (or at least the subset of it that covers normal use) is compact.

y usualmente en términos de la regla de simplicidad en la filosofía de Unix:

Add complexity only where you must.

En efecto, Fortran y C++ hacen fácil agregar complejidad innecesaria. En C, no es fácil agregar complejidad innecesaria. Por lo tanto, como bien dice Linus Torvalds una vez más en la cita del comienzo del capítulo, si con esta decisión lo único que pudiésemos hacer es evitar que se pueda agregar gratuitamente complejidad al código, esa ya sería una razón suficiente para tomarla.

4.1.1 Construcción de los objetos globales

Habiendo decidido entonces construir la matriz \mathsf{K} y el vector \mathbf{b} como una “glue layer” implementada en C utilizando una estructura de datos que PETSc pueda entender, preguntémonos ahora qué necesitamos para construir estos objetos. Para simplificar el argumento, supongamos por ahora que queremos resolver la ecuación generalizada de Poisson de la Sección 3.4.1. La matriz global \mathsf{K} proviene de ensamblar las matrices elementales \mathsf{K}_i para todos los elementos volumétricos e_i según la definición 3.23. De la misma manera, el vector global \mathbf{b}_i proviene de ensamblar las contribuciones elementales \mathbf{b}_i tanto de los elementos volumétricos (definición 3.24) como de los elementos de superficie con condiciones de contorno naturales (definición 3.25).

Una posible implementación en pseudo código de alto nivel de esta construcción podría ser la ilustrada en el algoritmo . La aplicación de las condiciones de contorno de Dirichlet según la discusión de la Sección 3.4.1.2 puede ser realizada con el algoritmo o con el algoritmo . En un caso barremos sobre elementos y tenemos que encontrar el índice global asociado a cada nodo local. En otro caso barremos sobre nodos globales pero tenemos que encontrar los elementos asociados al nodo global.

La primera conclusión que podemos extraer es que para problemas escalares, la ecuación a resolver está determinada por la expresión entre llaves de los términos evaluados en cada punto de Gauss para \mathsf{K}_i y para \mathbf{b}_i. Si el problema tuviese más de una incógnita por nodo y reemplazamos las matrices \mathsf{H}_c y \mathsf{B}_i por sus versiones G-aware \mathsf{H}_{Gc} y \mathsf{B}_{Gi}, entonces otra vez la ecuación a resolver está completamente definida por la expresión entre llaves.

Por ejemplo, si quisiéramos resolver difusión de neutrones multigrupo tendríamos que reemplazar el término entre llaves \mathsf{B}_i^T(\mathbf{\xi}_q) \cdot k(\mathbf{x}_q) \cdot \mathsf{B}_i(\mathbf{\xi}_q) en la ecuación 3.49 por \mathsf{L}_i + \mathsf{A}_i - \mathsf{F}_i para obtener la ecuación 3.62

\mathsf{K}_i \leftarrow \mathsf{K}_i + \omega_q \cdot \Big|\det{\left[\mathsf{J}_i\left(\mathbf{\xi}_q\right)\right]}\Big| \cdot \left\{ \mathsf{L}_i(\mathbf{\xi}_q) + \mathsf{A}_i(\mathbf{\xi}_q) - \mathsf{F}_i(\mathbf{\xi}_q)\right\} con las matrices intermedias según la ecuación 3.63

\tag{\ref{eq-LAF}} \begin{aligned} \mathsf{L}_i &= \mathsf{B}_{Gi}^T(\mathbf{\xi}_q) \cdot \mathsf{D}_D(\mathbf{\xi}_q) \cdot \mathsf{B}_{Gi}(\mathbf{\xi}_q) \\ \mathsf{A}_i &= \mathsf{H}_{Gc}^T(\mathbf{\xi}_q) \cdot \mathsf{R}(\mathbf{\xi}_q) \cdot \mathsf{H}_{Gc}(\mathbf{\xi}_q) \\ \mathsf{F}_i &= \mathsf{H}_{Gc}^T(\mathbf{\xi}_q) \cdot \mathsf{X}(\mathbf{\xi}_q) \cdot \mathsf{H}_{Gc}(\mathbf{\xi}_q) \end{aligned} más las contribuciones a la matriz de rigidez para condiciones de Robin. Pero en principio podríamos escribir un algoritmo genérico (¿una cáscara?) que implemente el método de elementos finitos para resolver una cierta ecuación diferencial completamente definida por la expresión dentro de las llaves (¿pasadas como argumentos?).

La segunda conclusión proviene de preguntarnos qué es lo que necesitan los algoritmos , y para construir la matriz de rigidez global \mathsf{K} y el vector \mathbf{b}:

- los conjuntos de cuadraturas de gauss \omega_q, \mathbf{\xi}_q para el elemento e_i

- las matrices canónicas \mathsf{H}_{c}, \mathsf{B}_{c} y \mathsf{H}_{Gc}

- las matrices elementales \mathsf{C}_i, \mathsf{B}_{Gi},

- poder evaluar en \mathbf{x}_q

- las conductividad k(\mathbf{x}) (o las secciones eficaces para construir \mathsf{D}_D(\mathbf{\xi}_q), \mathsf{R}(\mathbf{\xi}_q) y \mathsf{X}(\mathbf{\xi}_q))

- la fuente volumétrica f(\mathbf{x}) (o las fuentes independientes isotrópicas s_{0,g}(\mathbf{\xi}_q))

- las condiciones de contorno p(\mathbf{x}) y g(\mathbf{x}) (o las correspondientes a difusión de neutrones)

Los tres primeros puntos no dependen de la ecuación a resolver. Lo único que se necesita para evaluarlos es tener disponible la topología de la malla no estructurada que discretiza el dominio U \in \mathbb{R}^D a través la posición \mathbf{x}_j \in \mathbb{R}^D de los nodos y la conectividad de cada uno de los elementos e_i.

El cuarto en principio sí depende de la ecuación, pero finalmente se reduce a la capacidad de evaluar

- propiedades de materiales

- condiciones de contorno

en una ubicación espacial arbitraria \mathbf{x}.

Para fijar ideas, supongamos que tenemos un problema de conducción de calor. La conductividad k(\mathbf{x})19 o en general, cualquier propiedad material puede depender de la posición \mathbf{x} porque

- existen materiales con propiedades discontinuas en diferentes ubicaciones \mathbf{x}, y/o

- la propiedad depende continuamente de la posición aún para el mismo material.

De la misma manera, una condición de contorno (sea ésta esencial o natural) puede depender discontinuamente con la superficie donde esté aplicada o continuamente dentro de la misma superficie a través de alguna dependencia con la posición \mathbf{x}.

Entonces, la segunda conclusión es que si nuestra herramienta fuese capaz de proveer un mecanismo para definir propiedades materiales y condiciones de contorno que puedan depender

- discontinuamente según el volumen o superficie al que pertenezca cada elemento (algunos elementos volumétricos pertenecerán al combustible y otros al moderador, algunos elementos superficiales pertenecerán a una condición de simetría y otros a una condición de vacío), y/o

- continuamente en el espacio según variaciones locales (por ejemplo cambios de temperatura y/o densidad, concentración de venenos, etc.)

entonces podríamos resolver ecuaciones diferenciales arbitrarias discretizadas espacialmente con el método de elementos finitos.

4.1.2 Polimorfismo con apuntadores a función

Según la discusión de la sección anterior, podemos diferenciar entre dos partes del código:

Una que tendrá que realizar tareas “comunes”

- en el sentido de que son las mismas para todas las PDEs tal como leer la malla y evaluar funciones en un punto \mathbf{x} arbitrario del espacio

Otra parte que tendrá que realizar tareas particulares para cada ecuación a resolver

- por ejemplo evaluar las expresiones entre llaves en el q-ésimo punto de Gauss del elemento i-ésimo

Definición 4.1 (framework) Llamamos framework a la parte del código que implementa las tareas comunes.

Por decisión de diseño, el problema que FeenoX tiene que resolver tiene que estar completamente definido en el archivo de entrada. Esto es, no se debe necesitar intervención del usuario luego de la ejecución. Entonces, este archivo de entrada debe justamente definir qué clase de ecuación se debe resolver. Como el tipo de ecuación se lee en tiempo de ejecución, el framework debe poder ser capaz de llamar a una u otra (u otra) función que le provea la información particular que necesita: por ejemplo las expresiones entre llaves para la matriz de rigidez y para las condiciones de contorno.

Una posible implementación (ingenua) sería hacer, para cada punto de Gauss de cada uno de los elementos,

De la misma manera, necesitaríamos bloques if (o switch) de este tipo para

- inicializar el problema

- evaluar condiciones de contorno

- calcular resultados derivados (por ejemplo flujos de calor a partir de las temperaturas, tensiones a partir de desplazamientos o corrientes a partir de flujos neutrónicos)

- etc.

Está claro que esto es

- feo,

- ineficiente, y

- difícil de extender

En C++, podríamos diseñar una mejor implementación mediante una jerarquía de clases donde las clases hijas implementarían métodos virtuales que el framework llamaría cada vez que necesite evaluar el término entre llaves. Si bien C no tiene “métodos virtuales”, sí tiene apuntadores a función (que es justamente lo que PETSc usa para implementar polimorfismo ) por lo que podemos usar este mecanismo para lograr una implementación superior, que explicamos a continuación.

Por un lado, sí existe un lugar del código con un bloque if según el tipo de PDE requerida en tiempo de ejecución que consideramos feo, ineficiente y difícil de extender. Pero,

este único bloque de condiciones

ifse ejecutan una sola vez en el momento de analizar gramaticalmente20 el archivo de entrada y lo que hacen es resolver un apuntador a función a la dirección de memoria de una rutina de inicialización particular que el framework debe llamar antes de comenzar a construir \mathsf{K} y \mathbf{b}:if (strcasecmp(token, "laplace") == 0) { feenox.pde.init_parser_particular = feenox_problem_init_parser_laplace; } else if (strcasecmp(token, "mechanical") == 0) { feenox.pde.init_parser_particular = feenox_problem_init_parser_mechanical; } else if (strcasecmp(token, "modal") == 0) { feenox.pde.init_parser_particular = feenox_problem_init_parser_modal; } else if (strcasecmp(token, "neutron_diffusion") == 0) { feenox.pde.init_parser_particular = feenox_problem_init_parser_neutron_diffusion; } else if (strcasecmp(token, "neutron_sn") == 0) { feenox.pde.init_parser_particular = feenox_problem_init_parser_neutron_sn; } else if (strcasecmp(token, "thermal") == 0) { feenox.pde.init_parser_particular = feenox_problem_init_parser_thermal; } else { feenox_push_error_message("unknown problem type '%s'", token); return FEENOX_ERROR; }Estas funciones de inicialización a su vez resuelven los apuntadores a función particulares para evaluar contribuciones elementales volumétricas en puntos de Gauss, condiciones de contorno, post-procesamiento, etc.

El bloque

ifmostrado en el punto anterior es generado programáticamente a partir de un script (regla de Unix de generación, Sección C.14) que analiza (parsea) el árbol del código fuente y, para cada subdirectorio ensrc/pdes, genera un bloqueifautomáticamente. Es fácil ver el patrón que siguen cada una de las líneas del listado en el punto a y escribir un script o macro para generarlo programáticamente. De hecho en la Sección 4.1.4 mostramos una implementación simplificada de dicho script.

Entonces,

Si bien ese bloque sigue siendo feo, es generado y compilado por una máquina que no tiene el mismo sentido estético que nosotros.

Reemplazamos la evaluación de n condiciones

ifpara llamar a una dirección de memoria fija para cada punto de Gauss para cada elemento por una des-referencia de un apuntador a función. En términos de eficiencia, esto es similar (tal vez más eficiente) que un método virtual de C++. Esta des-referencia dinámica no permite que el compilador pueda hacer uninlinede la función llamada, pero el gasto extra21 es muy pequeño. En cualquier caso, el mismo script que “parsea” la estructura ensrc/pdespodría modificarse para generar un binario de FeenoX para cada PDE donde en lugar de llamar a un apuntador a función se llame directamente a las funciones propiamente dichas permitiendo optimización en tiempo de vinculación22 que le permita al compilador hacer elinlinede la función particular (ver Sección 4.4.4).El script que parsea la estructura de

src/pdesen busca de los tipos de PDEs disponibles es parte del pasoautogen.sh(ver la discusión de la Sección 4.1.4) dentro del esquemaconfigure+makede Autotools. Las PDEs soportadas por FeenoX puede ser extendidas agregando un nuevo subdirectorio dentro desrc/pdesdonde ya existentomando uno de estos subdirectorios como plantilla.23 De hecho también es posible eliminar completamente uno de estos directorios en el caso de no querer que FeenoX pueda resolver alguna PDE en particular. De esta forma,

autogen.shpermite extender (o reducir) la funcionalidad del código, que es uno de los puntos solicitados en el SDS. Más aún, sería posible utilizar este mecanismo para cargar funciones particulares desde objetos compartidos24 en tiempo de ejecución (utilizando la funcióndlopenpor ejemplo), incrementando aún más la extensibilidad de la herramienta.

4.1.3 Definiciones e instrucciones

En la Sección 1.2 mencionamos (y en el apéndice B explicamos en detalle) que la herramienta desarrollada es una especie de “función de transferencia” entre uno o más archivos de entrada y cero o más archivos de salida (incluyendo la salida estándar stdout). En la figura 4.1 ilustramos nuevamente esta idea para un cierto problema particular, digamos el Benchmark 3D PWR de IAEA mencionado en el capítulo 1. Este archivo de entrada, que a su vez puede incluir otros archivos de entrada y/o hacer referencia a otros archivos de datos (incluyendo la malla en formato .msh) contiene palabras clave25 en inglés que, por decisión de diseño, deben

- definir completamente el problema de resolver

- ser lo más auto-descriptivas posible

- permitir una expresión algebraica en cualquier lugar donde se necesite un valor numérico

- mantener una correspondencia uno a uno entre la definición “humana” del problema y el archivo de entrada

- hacer que el archivo de entrada de un problema simple sea simple

Estas keywords pueden ser

definiciones26 (sustantivos)

- qué PDE hay que resolver

- propiedades materiales

- condiciones de contorno

- variables, vectores y/o funciones auxiliares

- etc.

instrucciones (verbos)

- leer la malla

- resolver problema

- asignar valores a variables

- calcular integrales o encontrar extremos sobre la malla

- escribir resultados

- etc.

Por un lado, las definiciones se realizan a tiempo de parseo. Por otro lado, Una vez que FeenoX acepta que el archivo de entrada es válido, comienza la ejecución de las instrucciones en el orden indicado en el archivo de entrada. De hecho, FeenoX tiene un apuntador a instrucción27 que recorre una lista a medida que avanza la ejecución de las instrucciones, pero teniendo en cuenta que existe palabras clave (como IF y WHILE) que permiten flujos de ejecución no triviales, especialmente en problemas iterativos, cuasi-estáticos o transitorios:

// sweep the first & last range but minding the conditional blocks

instruction_t *ip = first;

while (ip != last) {

feenox_call(ip->routine(ip->argument));

if (feenox.next_instruction != NULL) {

ip = feenox.next_instruction;

feenox.next_instruction = NULL;

} else {

ip = ip->next;

}

}Por ejemplo, en

f(x) = x^2

PRINT f(1/2) f(1) f(2)la primera línea es una definición (dada por el signo =) y la segunda es una instrucción (verbo PRINT).

En particular, la lectura del archivo de malla es una instrucción y no una definición porque

el nombre del archivo de la malla puede depender de alguna variable cuyo valor deba ser evaluado en tiempo de ejecución con una instrucción previa. Por ejemplo

INPUT_FILE surprise PATH nafems-le1%g.msh round(random(0,1)) READ_MESH surprise PRINT cells$ feenox surprise.fee 18700 $ feenox surprise.fee 18700 $ feenox surprise.fee 32492 $ feenox surprise.fee 32492 $ feenox surprise.fee 18700 $el archivo con la malla en sí puede ser creado internamente por FeenoX con una instrucción previa

WRITE_MESHy/o modificada en tiempo de ejecuciónREAD_MESH square.msh SCALE 1e-3 WRITE_MESH square_tmp.vtk INPUT_FILE tmp PATH square_tmp.vtk READ_MESH tmpen problemas complejos puede ser necesario leer varias mallas antes de resolver la PDE en cuestión, por ejemplo leer una distribución de temperaturas en una malla gruesa de primer orden para utilizarla al evaluar las propiedades de los materiales de la PDE que se quiere resolver. Ver Sección 5.1 y Sección B.3.2.2.

Comencemos con un problema sencillo para luego agregar complejidad en forma incremental. A la luz de la discusión de este capítulo, preguntémonos ahora qué necesitamos para resolver un problema de conducción de calor estacionario sobre un dominio U \in \mathbb{R}^D con un único material:

- definir que la PDE es conducción de calor en D dimensiones

- leer la malla con el dominio U \in \mathbb{R}^D discretizado

- definir la conductividad térmica k(\mathbf{x}) del material

- definir las condiciones de contorno del problema

- construir \mathsf{K} y \mathbf{b}

- resolver \mathsf{K} \cdot \mathbf{u} = \mathbf{b}

- hacer lo que nos haya pedido el usuario en el archivo de entrada con los resultados, por ejemplo

- calcular T_\text{max}

- calcular T_\text{mean}

- calcular el vector flujo de calor q^{\prime \prime}(\mathbf{x}) = -k(\mathbf{x}) \cdot \nabla T

- comparar con soluciones analíticas

- etc.

- escribir los resultados

El problema de conducción de calor más sencillo es un slab unidimensional en el intervalo x \in [0,1] con conductividad uniforme y condiciones de Dirichlet T(0)=0 y T(1)=1 en ambos extremos. Por diseño, el archivo de entrada tiene que ser sencillo (porque dijimos que el problema es sencillo, en el capítulo 5 vamos a ver problemas más complicados con inputs complicados) y tener una correspondencia uno a uno con la definición “humana” del problema:

PROBLEM thermal 1D # 1. definir que la PDE es calor 1D

READ_MESH slab.msh # 2. leer la malla

k = 1 # 3. definir conductividad uniforme igual a uno

BC left T=0 # 4. condiciones de contorno de Dirichlet

BC right T=1 # "left" y "right" son nombres en la malla

SOLVE_PROBLEM # 5. y 6. construir y resolver

PRINT T(0.5) # 7. y 8. escribir en stdout la temperatura en x=0.5En este caso sencillo, la conductividad k fue dada como una variable k con un valor igual a uno. Estrictamente hablando, la asignación fue una instrucción. Pero en el momento de resolver el problema, las funciones particulares de la PDE de conducción de calor (dentro de src/pdes/thermal) buscan una variable llamada k y toman su valor para utilizarlo idénticamente en todos los puntos de Gauss de los elementos volumétricos al calcular el término \mathsf{B}_i^T \cdot k \cdot \mathsf{B}_i.

Si la conductividad no fuese uniforme sino que dependiera del espacio por ejemplo como

k(x) = 1+x entonces el archivo de entrada sería

PROBLEM thermal 1D

READ_MESH slab.msh

k(x) = 1+x # 3. conductividad dada por una función de x

BC left T=0

BC right T=1

SOLVE_PROBLEM

PRINT T(1/2) log(1+1/2)/log(2) # 7. y 8. imprimir el valor numérico y la solución analíticaEn este caso, no hay una variable llamada k sino que hay una función de x (definida con una definición) con la expresión algebraica 1+x. Entonces la rutina particular dentro de src/pde/thermal que evalúa las contribuciones volumétricas elementales de la matriz de rigidez toma dicha función k(x) como la propiedad “conductividad” y la evalúa como \mathsf{B}_i^T(\mathbf{x}_q) \cdot k(\mathbf{x}_q) \cdot \mathsf{B}_i(\mathbf{x}_q). La salida, que por diseño está 100% definida por el archivo de entrada (reglas de Unix de silencio Sección C.11 y de economía Sección C.13) consiste en la temperatura evaluada en x=1/2 junto con la solución analítica \log(1+\frac{1}{2})/\log(2) en dicho punto.

Por completitud, mostramos que también la conductividad podría depender de la temperatura. En este caso particular el problema resulta no lineal. Mencionamos algunas particularidades sin ahondar en detalles. El parser algebraico de FeenoX sabe que k depende de T, por lo que la rutina particular de inicialización de la PDE de conducción de calor marca que el problema debe ser resuelto por PETSc con un objeto SNES en lugar de un KSP como para el caso lineal. FeenoX también calcula el jacobiano necesario para resolver el problema con un método de Newton iterativo, que incluye un término proporcional a \partial k / \partial T:

PROBLEM thermal 1D

READ_MESH slab.msh

k(x) = 1+T(x) # 3. la conductividad ahora depende de T(x)

BC left T=0

BC right T=1

SOLVE_PROBLEM

PRINT T(1/2) sqrt(1+(3*0.5))-1La ejecución de FeenoX sigue también las reglas tradicionales de Unix. Se debe proveer la ruta al archivo de entrada como principal argumento luego del ejecutable. Es un argumento y no como una opción ya que la funcionalidad del programa depende de que se indique un archivo de entrada, por lo que no es “opcional”. Sí se pueden agregar opciones siguiendo las reglas POSIX. Algunas opciones son para FeenoX (por ejemplo --progress o --elements_info y otras son pasadas a PETSc/SLEPc (por ejemplo --ksp_view o --mg_levels_pc_type=sor). Al ejecutar los tres casos anteriores, obtenemos los resultados solicitados con la instrucción PRINT en la salida estándar:

$ feenox thermal-1d-dirichlet-uniform-k.fee

0.5

$ feenox thermal-1d-dirichlet-space-k.fee

0.584945 0.584963

$ feenox thermal-1d-dirichlet-temperature-k.fee

0.581139 0.581139

$ Para el caso de conducción de calor estacionario solamente hay una única propiedad cuyo nombre debe ser k para que las rutinas particulares la detecten como la conductividad k que debe aparecer en la contribución volumétrica. Si el problema tuviese dos materiales diferentes, digamos A y B (es decir, en la malla hubiera algunos elementos asociados a la etiqueta volumétrica A y otros a la etiqueta B) entonces habría dos maneras de definir sus propiedades materiales en FeenoX:

agregando el sufijo

_Ay_Ba la variableko a la funciónk(x), es decirk_A = 1 k_B = 2si k_A = 1 y k_B=2, o

k_A(x) = 1+2*x k_B(x) = 3+4*xsi k_A(x) = 1+2x y k_B(x) = 3+4x.

utilizando una palabra clave

MATERIAL(definición) para ´cada material, del siguiente modoMATERIAL A k=1 MATERIAL B k=2o

MATERIAL A k=1+2*x MATERIAL B k=3+4*x

De esta forma, el framework implementa las dos posibles dependencias de las propiedades de los materiales discutidas:

- continua con el espacio a través de expresiones algebraicas que pueden involucrar funciones definidas por puntos en interpoladas como discutimos en la Sección 4.3, y

- discontinua según el material al que pertenece el elemento.

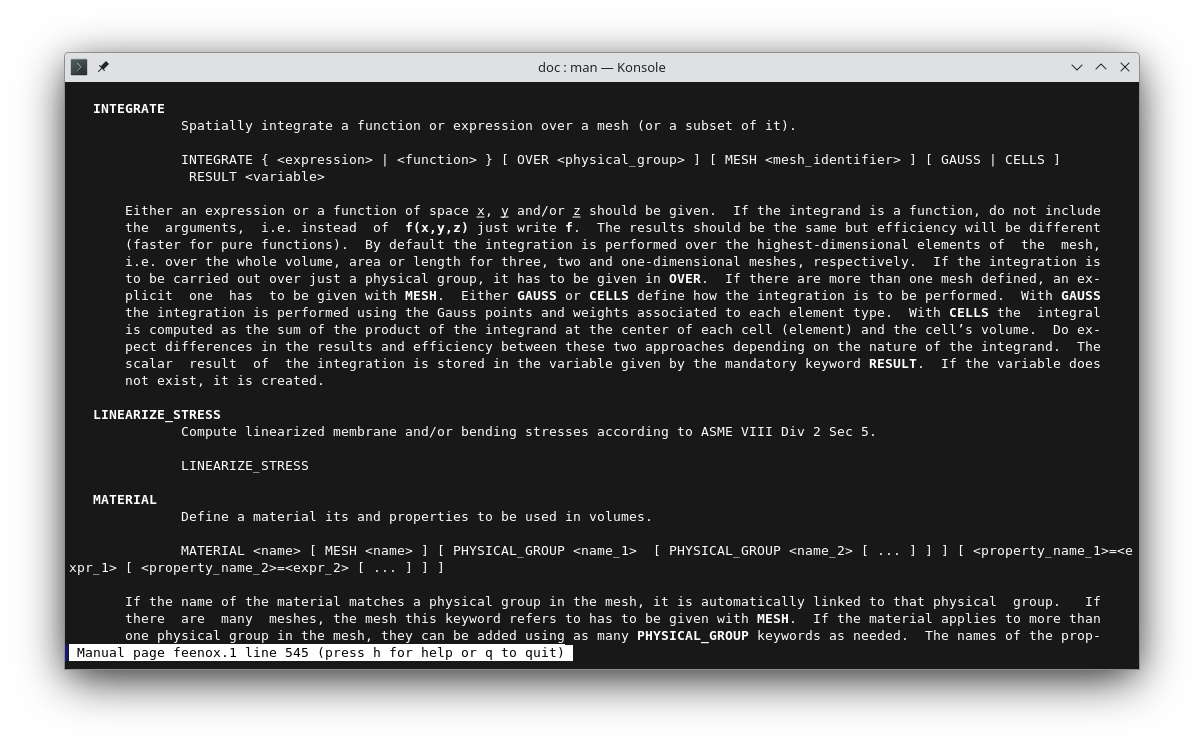

Con respecto a las condiciones de contorno, la lógica es similar pero ligeramente más complicada. Mientras que a partir del nombre de la propiedad material (incluyendo las fuentes volumétricas) las rutinas particulares pueden evaluar las contribuciones volumétricas, sean a la matriz de rigidez \mathsf{K} a través de la conductividad k o al vector \mathbf{b} a través de la fuente de calor por unidad de volumen q, para las condiciones de contorno se necesita un poco más de información. Supongamos que una superficie tiene una condición de “simetría” y que queremos que la línea del archivo de entrada que la defina sea

BC left symmetrydonde left es el nombre de la entidad superficial definida en la malla y symmetry es una palabra clave que indica qué tipo de condición de contorno tienen los elementos que pertenecen a left. La forma de implementar numéricamente (e incluso físicamente) esta condición de contorno depende de la PDE que estamos resolviendo. No es lo mismo poner una condición de simetría en las ecuaciones de

- poisson generalizada

- elasticidad lineal

- difusión de neutrones

- transporte por S_N

Entonces, si bien las propiedades de materiales pueden ser parseadas por el framework y aplicadas por las rutinas particulares, las condiciones de contorno deben ser parseadas y aplicadas por las rutinas particulares. De todas maneras, la lógica es similar: las rutinas particulares proveen puntos de entrada28 que el framework llama en los momentos pertinentes durante la ejecución de las instrucciones.

Para terminar de ilustrar la idea, consideremos el problema de Reed (discutido en detalle en la Sección 5.2) que propone resolver con S_N un slab uni-dimensional compuesto por varios materiales, algunos con una fuente independiente, otros sin fuente e incluso un material de vacío:

#

# | | | | | |

# m | src= 50 | 0 | 0 | 1 | 0 | v

# i | | | | | | a

# r | tot= 50 | 5 | 0 | 1 | 1 | c

# r | | | | | | u

# o | scat=0 | 0 | 0 | 0.9| 0.9 | u

# r | | | | | | m

# | | | | | |

# | 1 | 2 | 3 | 4 | 5 |

# | | | | | |

# +---------+----+---------+----+---------+-------> x

# x=0 x=2 x=3 x=5 x=6 x=8

PROBLEM neutron_sn DIM 1 GROUPS 1 SN $1

READ_MESH reed.msh

MATERIAL source_abs S1=50 Sigma_t1=50 Sigma_s1.1=0

MATERIAL absorber S1=0 Sigma_t1=5 Sigma_s1.1=0

MATERIAL void S1=0 Sigma_t1=0 Sigma_s1.1=0

MATERIAL source_scat S1=1 Sigma_t1=1 Sigma_s1.1=0.9

MATERIAL reflector S1=0 Sigma_t1=1 Sigma_s1.1=0.9

BC left mirror

BC right vacuum

SOLVE_PROBLEM

FUNCTION ref(x) FILE reed-ref.csv INTERPOLATION steffen

PRINT sqrt(integral((ref(x)-phi1(x))^2,x,0,8))/8La primera línea es una definición (

PROBLEMes un sustantivo) que le indica a FeenoX que debe resolver las ecuaciones S_N en D=1 dimensión con G=1 grupo de energías y utilizando una discretización angular N dada por el primer argumento $1 de la línea de comando luego del nombre del archivo de entrada. De esta manera se pueden probar diferentes discretizaciones con el mismo archivo de entrada, digamosreed.fee$ feenox reed 2 # <- S2 [...] $ feenox reed 4 # <- S4 [...]La segunda línea es una instrucción (el verbo

READ) que indica que FeenoX debe leer la malla donde resolver problema del archivoreed.msh. Si el archivo de entrada se llamarareed.fee, esta línea podría haber sidoREAD_MESH $0.msh. En caso de leer varias mallas, la que define el dominio de la PDE es- la primera de las instrucciones

READ_MESH, o - la definida explícitamente con la palabra clave

MAIN_MESH

- la primera de las instrucciones

El bloque de palabras clave

MATERIALdefinen (con un sustantivo) las secciones eficaces macroscópicas (Sigma) y las fuentes independientes (S). En este caso todas las propiedades son uniformes dentro de cada material.Las siguientes dos líneas definen las condiciones de contorno (

BCes la abreviación boundary condition que es un sustantivo adjetivado): la superficielefttiene una condición de simetría (o espejo) y la superficierighttiene una condición de vacío.La instrucción

SOLVE_PROBLEMle pide a FeenoX que- construya la matriz global \mathsf{K} y el vector \mathbf{b} (pidiéndole a su vez el integrando a las rutinas específicas del subdirectorio

src/pdes/neutron_sn) - que le pida a su vez a PETSc que resuelva el problema \mathsf{K} \cdot \mathbf{u} = \mathbf{b} (como hay fuentes independientes entonces la rutina de inicialización del problema

neutron_snsabe que debe resolver un problema lineal, si no hubiese fuentes y sí secciones eficaces de fisión se resolvería un problema de autovalores con la biblioteca SLEPc) - que extraiga los valores nodales de la solución \mathbf{u} y defina las funciones del espacio \psi_{mg}(x) y \phi_{g}(x). Si

$1fuese2entonces las funciones con la solución seríanpsi1.1(x)psi1.2(x)phi1(x)

$1fuese4entonces seríanpsi1.1(x)psi1.2(x)psi1.3(x)psi1.4(x)phi1(x)

WRITE_MESH, como parte de otras expresiones intermedias, etc. - Si el problema fuese de criticidad, entonces esta instrucción también pondría el valor del factor de multiplicación efectivo k_\text{eff} en una variable llamada

keff.

- construya la matriz global \mathsf{K} y el vector \mathbf{b} (pidiéndole a su vez el integrando a las rutinas específicas del subdirectorio

La siguiente línea define una función auxiliar de la variable espacial x a partir de un archivo de columnas de datos. Este archivo contiene una solución de referencia del problema de Reed. La función

ref(x)puede ser evaluada en cualquier punto x utilizando una interpolación monotónica cúbica de tiposteffen[18].La última línea imprime en la salida estándar una representación ASCII (por defecto utilizando el formato

%gde la instrucciónprintf()de C) del error L_2 cometido por la solución calculada con FeenoX con respecto a la solución de referencia, es decir

\frac{1}{8} \cdot \sqrt{\int_0^8 \left[ \text{ref}(x) - \phi_1(x) \right]^2}

La ejecución de FeenoX con este archivo de entrada para S_2, S_4, S_6 y S_8 da como resultado

$ feenox reed.fee 2

0.0505655

$ feenox reed.fee 4

0.0143718

$ feenox reed.fee 6

0.010242

$ feenox reed.fee 8

0.0102363

$ 4.1.4 Puntos de entrada

La compilación del código fuente usa el procedimiento recomendado por GNU donde el script configure genera los archivos de make29 según

- la arquitectura del hardware (Intel, ARM, etc.)

- el sistema operativo (GNU/Linux, otras variantes, etc.)

- las dependencias disponibles (MPI, PETSc, SLEPc, GSL, etc.)

A su vez, para generar este script configure se suele utilizar el conjunto de herramientas conocidas como Autotools. Estas herramientas generan, a partir de un conjunto de definiciones reducidas dadas en el lenguaje de macros M4, no sólo el script configure sino también otros archivos relacionados al proceso de compilación tales como los templates para los makefiles. Estas definiciones reducidas (que justamente definen las arquitecturas y sistemas operativos soportados, las dependencias, etc.) usualmente se dan en un archivo de texto llamado configure.ac y los templates que indican dónde están los archivos fuente que se deben compilar en archivos llamados Makefile.am ubicados en uno o más subdirectorios. Éstos últimos se referencian desde configure.ac de forma tal que Autoconf y Automake trabajen en conjunto para generar el script configure, que forma parte de la distribución del código fuente de forma tal que un usuario arbitrario pueda ejecutarlo y luego compilar el código con el comando make, que lee el Makefile generado por configure.

Para poder implementar la idea de extensibilidad según la cual FeenoX podría resolver diferentes ecuaciones en derivadas parciales, le damos una vuelta más de tuerca a esta idea de generar archivos a partir de scripts. Para ello empleamos la idea de bootstrapping (figura 4.2), en la cual el archivo configure.ac y/o las plantillas Makefile.am son generadas a partir de un script llamado autogen.sh (algunos autores prefieren llamarlo bootstrap).

bootstrap (también llamado autogen.sh).Este script autogen.sh detecta qué subdirectorios hay dentro del directorio src/pdes y, para cada uno de ellos, agrega unas líneas a un archivo fuente llamado src/pdes/parse.c que hace apuntar un cierto apuntador a función a una de las funciones definidas dentro del subdirectorio. En forma resumida,

for pde in *; do

if [ -d ${pde} ]; then

if [ ${first} -eq 0 ]; then

echo -n " } else " >> parse.c

else

echo -n " " >> parse.c

fi

cat << EOF >> parse.c

if (strcasecmp(token, "${pde}") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_${pde};

EOF

first=0

fi

doneEsto generaría el bloque de ifs feo que ya mencionamos en parse.c:

if (strcasecmp(token, "laplace") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_laplace;

} else if (strcasecmp(token, "mechanical") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_mechanical;

} else if (strcasecmp(token, "modal") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_modal;

} else if (strcasecmp(token, "neutron_diffusion") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_neutron_diffusion;

} else if (strcasecmp(token, "neutron_sn") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_neutron_sn;

} else if (strcasecmp(token, "thermal") == 0) {

feenox.pde.parse_problem = feenox_problem_parse_problem_thermal;

} else {

feenox_push_error_message("unknown problem type '%s'", token);

return FEENOX_ERROR;

}Estas instrucciones son llamadas desde el parser general luego de haber leído la definición PROBLEM. Por ejemplo, si en el archivo de entrada se encuentra esta línea

PROBLEM laplaceentonces el apuntador a función feenox.pde.parse_problem declarado en feenox.h como

int (*parse_problem)(const char *token);apuntaría a la función feenox_problem_parse_problem_laplace() declarada en src/pdes/laplace/methods.h y definida en src/pdes/laplace/parser.c. De hecho, esta función es llamada con el parámetro token conteniendo cada una de las palabras que está a continuación del nombre del problema que el parser general no entienda. En particular, para la línea

PROBLEM neutron_sn DIM 3 GROUPS 2 SN 8lo que sucede en tiempo de parseo es

La palabra clave primaria

PROBLEMes leída (y entendida) por el parser general.El argumento

neutron_snes leído por el bloque generado porautogen.sh. El apuntador a la función globalfeenox.pde.parse_problemse hace apuntar entonces a la función provista ensrc/pdes/neutron_snllamadafeenox_problem_parse_problem_neutron_sn().La palabra clave secundaria

DIMes leída por el parser general. Como es una palabra clave secundaria asociada a la primariaPROBLEMy el parser general la entiende (ya que el framework tiene que saber la dimensión espacial de la ecuación diferencial en derivadas parciales que tiene que resolver, entonces la parsea). Seguidamente, lee el siguiente argumento3(que puede ser una expresión como comentamos más adelante) y sabe que tiene que resolver una ecuación diferencial sobre tres dimensiones espaciales. Esto implica, por ejemplo, definir que las propiedades de los materiales y las soluciones serán funciones de tres argumentos: x, y y z.La palabra clave secundaria

GROUPSes leída por el parser general. Como no es una palabra clave secundaria asociada a la primaraPROBLEM, entonces se llama afeenox.pde.parse_problem(que apunta afeenox_problem_parse_problem_neutron_sn()) con el argumentotokenapuntando aGROUPS.Como el parser particular dentro de

src/pdes/neutron_snsí entiende que la palabra claveGROUPSdefine la cantidad de grupos de energía, lee el siguiente token2(que también puede ser una expresión, ver Sección 4.2), lo entiende como tal y lo almacena en la estructura de datos particular de las rutinas correspondientes aneutron_sn.El control vuelve al parser principal que lee la siguiente palabra clave secundaria

SN. Como tampoco la entiende, vuelve a llamar al parser particular que entiende que debe utilizar las direcciones y pesos de S_8.Una vez más el control vuelve al parser principal, que llega al final de la línea. En este momento, vuelve a llamar al parser específico

feenox_problem_parse_problem_neutron_sn()pero pasandoNULLcomo argumento. En este punto, se considera que el parser específico ya tiene toda la información necesaria para inicializar (al menos una parte) de sus estructuras internas y de las variables o funciones que deben estar disponibles para otras palabras claves genéricas. Por ejemplo, si el problema es neutrónico entonces inmediatamente después de haber parseado completamente la líneaPROBLEMdebe definirse la variablekeffy las funciones con los flujos escalares (y angulares si correspondiere) de forma tal que las siguientes líneas, que serán interpretadas por el parser genérico, entiendan quekeffes una variable y quephi1(x,y,z),psi1.1(x,y,z)ypsi2.8(x,y,z)son expresiones válidas:PRINT "keff = " keff PRINT " rho = " (1-keff)/keff PRINT psi1.1(0,0,0) psi8.2(0,0,0) profile(x) = phi1(x,x,0) PRINT_FUNCTION profile phi1(x,0,0) MIN 0 MAX 20 NSTEPS 100

Dentro de las inicializaciones en tiempo de parseo, cada implementación específica debe resolver el resto de los apuntadores a función que definen los puntos de entrada específicos que el framework principal necesita llamar para

parsear partes específicas del archivo de entrada

- condiciones de contorno

- la palabra clave

WRITE_RESULTSque escribe “automáticamente” los resultados en un archivo de post-procesamiento en formato.msho.vtk. Esto es necesario ya que las rutinas que escriben los resultados son parte del framework general pero dependiendo de la PDE a resolver e incluso de los detalles de la PDE (por ejemplo la cantidad de grupos de energía en un problema neutrónico o la cantidad de modos calculadas en un problema de análisis de modos naturales de oscilación mecánicos).

inicializar estructuras internas

reservar la memoria virtual necesaria con una llamada al sistema operativo30 y construir las matrices y los vectores globales

resolver las ecuaciones discretizadas con PETSc (o SLEPc) según el tipo de problema resultante:

- problema lineal en estado estacionario \mathsf{K} \cdot \mathbf{u} = \mathbf{b} (PETSc KSP)

- problema generalizado de autovalores \mathsf{K} \cdot \mathbf{u} = \lambda \cdot \mathsf{M} \cdot \mathbf{u} (SLEPc EPS)

- problema no lineal en estado estacionario \mathbf{F}(\mathbf{u}) = 0 (PETSc SNES)

- problema transitorio \mathbf{G}(\mathbf{u}, \dot{\mathbf{u}}, t) = 0 (PETSc TS)

calcular campos secundarios a partir de los primarios (ver Sección 4.1.4.5), por ejemplo

- flujos escalares a partir de flujos angulares

- corrientes a partir de flujos neutrónicos

- flujos de calor a partir de temperaturas

- tensiones a partir de deformaciones

- etc.

// parse

int (*parse_problem)(const char *token);

int (*parse_write_results)(mesh_write_t *mesh_write, const char *token);

int (*parse_bc)(bc_data_t *bc_data, const char *lhs, char *rhs);

// init

int (*init_before_run)(void);

int (*setup_pc)(PC pc);

int (*setup_ksp)(KSP ksp);

int (*setup_eps)(EPS eps);

int (*setup_ts)(TS ksp);

// build

int (*element_build_volumetric)(element_t *e);

int (*element_build_volumetric_at_gauss)(element_t *e, unsigned int q);

// solve

int (*solve)(void);

// post

int (*solve_post)(void);

int (*gradient_fill)(void);

int (*gradient_nodal_properties)(element_t *e, mesh_t *mesh);

int (*gradient_alloc_nodal_fluxes)(node_t *node);

int (*gradient_add_elemental_contribution_to_node)(node_t *node, element_t *e, unsigned int j, double rel_weight);

int (*gradient_fill_fluxes)(mesh_t *mesh, size_t j_global);4.1.4.1 Parseo

Cuando se termina la línea de PROBLEM, el parser general llama a parse_problem(NULL) que debe

terminar de rellenar los apuntadores específicos

// virtual methods feenox.pde.parse_bc = feenox_problem_bc_parse_neutron_diffusion; feenox.pde.parse_write_results = feenox_problem_parse_write_post_neutron_diffusion; feenox.pde.init_before_run = feenox_problem_init_runtime_neutron_diffusion; feenox.pde.setup_eps = feenox_problem_setup_eps_neutron_diffusion; feenox.pde.setup_ksp = feenox_problem_setup_ksp_neutron_diffusion; feenox.pde.setup_pc = feenox_problem_setup_pc_neutron_diffusion; feenox.pde.element_build_volumetric = feenox_problem_build_volumetric_neutron_diffusion; feenox.pde.element_build_volumetric_at_gauss = feenox_problem_build_volumetric_gauss_point_neutron_diffusion; feenox.pde.solve_post = feenox_problem_solve_post_neutron_diffusion;inicializar lo que necesita el parser para poder continuar leyendo el problema específico, incluyendo

la definición de variables especiales (por ejemplo los flujos escalares

phi_1,phi_2, etc. y angularespsi_1.1,psi_1.2, ,psi_2.12y las variableskeffysn_alpha) para que estén disponibles para el parser algebraico (ver Sección 4.2)// NOTE: it is more natural to put first the group and then the direction // while in the doc we use $\psi_{mg}$ for (unsigned int g = 0; g < neutron_sn.groups; g++) { for (unsigned int m = 0; m < neutron_sn.directions; m++) { feenox_check_minusone(asprintf(&feenox.pde.unknown_name[sn_dof_index(m,g)], "psi%u.%u", g+1, m+1)); } } // the scalar fluxes phi feenox_check_alloc(neutron_sn.phi = calloc(neutron_sn.groups, sizeof(function_t *))); for (unsigned int g = 0; g < neutron_sn.groups; g++) { char *name = NULL; feenox_check_minusone(asprintf(&name, "phi%u", g+1)); feenox_call(feenox_problem_define_solution_function(name, &neutron_sn.phi[g], FEENOX_SOLUTION_NOT_GRADIENT)); feenox_free(name); } neutron_sn.keff = feenox_define_variable_get_ptr("keff"); neutron_sn.sn_alpha = feenox_define_variable_get_ptr("sn_alpha"); feenox_var_value(neutron_sn.sn_alpha) = 0.5;la colocación de opciones por defecto (¿qué pasa si no hay keywords

GROUPSoSN?)// default is 1 group if (neutron_sn.groups == 0) { neutron_sn.groups = 1; } // default is N=2 if (neutron_sn.N == 0) { neutron_sn.N = 2; } if (neutron_sn.N % 2 != 0) { feenox_push_error_message("number of ordinates N = %d has to be even", neutron_sn.N); return FEENOX_ERROR; } // stammler's eq 6.19 switch(feenox.pde.dim) { case 1: neutron_sn.directions = neutron_sn.N; break; case 2: neutron_sn.directions = 0.5*neutron_sn.N*(neutron_sn.N+2); break; case 3: neutron_sn.directions = neutron_sn.N*(neutron_sn.N+2); break; } // dofs = number of directions * number of groups feenox.pde.dofs = neutron_sn.directions * neutron_sn.groups;la inicialización de direcciones \hat{\mathbf{\Omega}}_m y pesos w_m para S_N

Cuando una línea contiene la palabra clave principal BC tal como

BC left mirror

BC right vacuumentonces el parser principal lee el token siguiente, left y right respectivamente, que intentará vincular con un grupo físico en la malla del problema. Los siguientes tokens, en este caso sólo uno para cada caso, son pasados al parser específico feenox.pde.parse_bc que sabe qué hacer con las palabras mirror y vacuum. Este parser de condiciones de contorno a su vez resuelve uno de los dos apuntadores

int (*set_essential)(bc_data_t *, element_t *, size_t j_global);

int (*set_natural)(bc_data_t *, element_t *, unsigned int q);dentro de la estructura asociada a la condición de contorno según corresponda al tipo de condición.

4.1.4.2 Inicialización

Luego de que el parser lee completamente el archivo de entrada, FeenoX ejecuta las instrucciones en el orden adecuado, opcional y/o posiblemente siguiendo lazos de control y bucles.31 Al llegar a la instrucción SOLVE_PROBLEM, llama al punto de entrada init_before_run() donde

Se leen las expresiones que definen las propiedades de los materiales, que no estaban disponibles en el momento de la primera inicialización después de leer la línea

PROBLEM. Estas propiedades de materiales en general y las secciones eficaces macroscópicas en particular pueden estar dadas por- variables

- funciones del espacio

- la palabra clave

MATERIAL

En este momento de la ejecución todas las secciones eficaces deben estar definidas con nombres especiales. Por ejemplo,

- \Sigma_{tg} =

"Sigma_t%d" - \Sigma_{ag} =

"Sigma_a%d" - \nu\Sigma_{fg} =

"nuSigma_f%d" - \Sigma_{s_0 g \rightarrow g^\prime} =

"Sigma_s%d.%d" - \Sigma_{s_1 g \rightarrow g^\prime} =

"Sigma_s_one%d.%d" - S_g =

"S%d"

Dependiendo de si hay fuentes de fisión y/o fuentes independientes se determina si hay que resolver un problema lineal o un problema de autovalores generalizado. En el primer caso se hace

feenox.pde.math_type = math_type_linear; feenox.pde.solve = feenox_problem_solve_petsc_linear; feenox.pde.has_mass = 0; feenox.pde.has_rhs = 1;y en el segundo

feenox.pde.math_type = math_type_eigen; feenox.pde.solve = feenox_problem_solve_slepc_eigen; feenox.pde.has_mass = 1; feenox.pde.has_rhs = 0;

Luego de esta segunda inicialización, se llama al apuntador feenox.pde.solve que para neutrónica es o bien

feenox_problem_solve_petsc_linear()que construye \mathsf{K} y \mathbf{b} y resuelve \mathsf{K} \cdot \mathbf{u} = \mathbf{b}, ofeenox_problem_solve_slepc_eigen()que construye \mathsf{K} y \mathsf{M} y resuelve \mathsf{K} \cdot \mathbf{u} = \lambda \cdot \mathsf{M} \cdot \mathbf{u}.

Antes de construir y resolver las ecuaciones, se llama a su vez a los apuntadores a función que correspondan

feenox_pde.setup_pc(PC pc)feenox.pde.setup_ksp(KSP kps)feenox.pde.setup_eps(EPS eps)

donde cada problema particular configura el pre-condicionador, el solver lineal y el solver de autovalores en caso de que el usuario no haya elegido algoritmos explícitamente en el archivo de entrada. Si el operador diferencial es elíptico y simétrico (por ejemplo para conducción de calor o elasticidad lineal) tal vez convenga usar por defecto un solver iterativo basado en gradientes conjugados pre-condicionado con multi-grilla geométrica-algebraica32 [2]. En cambio para un operador hiperbólico no simétrico (por ejemplo S_N multigrupo) es necesario un solver más robusto como por ejemplo LU.

4.1.4.3 Construcción

Para construir las matrices globales \mathsf{K} y/o \mathsf{M} y/o el vector global \mathbf{b}, el framework general hace un bucle sobre todos los elementos volumétricos (locales a cada proceso) y, para cada uno de ellos, primero llama al punto de entrada feenox.pde.element_build_volumetric() que toma un apuntador al elemento como único argumento. Cada elemento es una estructura tipo element_t definida en feenox.h como

struct element_t {

size_t index;

size_t tag;

double quality;

double volume;

double area;

double size;

double gradient_weight; // this weight is used to average the contribution of this element to nodal gradients

double *w; // weights of the gauss points time determinant of the jacobian

double **x; // coordinates fo the gauss points

double *normal; // outward normal direction (only for 2d elements)

// matrix with the coordinates (to compute the jacobian)

gsl_matrix *C;

element_type_t *type; // pointer to the element type

physical_group_t *physical_group; // pointer to the physical group this element belongs to

node_t **node; // pointer to the nodes, node[j] points to the j-th local node

cell_t *cell; // pointer to the associated cell (only for FVM)

};Luego el framework general hace un sub-bucle sobre el índice q de los puntos de Gauss y llama a feenox.pde.element_build_volumetric_at_gauss() que toma el apuntador al elemento y el índice q como argumentos:

// if the specific pde wants, it can loop over gauss point in the call

// or it can just do some things that are per-element only and then loop below

if (feenox.pde.element_build_volumetric) {

feenox_call(feenox.pde.element_build_volumetric(this));

}

// or, if there's an entry point for gauss points, then we do the loop here

if (feenox.pde.element_build_volumetric_at_gauss != NULL) {

int Q = this->type->gauss[feenox.pde.mesh->integration].Q;

for (unsigned int q = 0; q < Q; q++) {

feenox_call(feenox.pde.element_build_volumetric_at_gauss(this, q));

}

}Estos dos métodos son responsables de devolver los objetos elementales volumétricos \mathsf{K}_i, \mathsf{M}_i como matrices densas en formato de la GNU Scientific Library gsl_matrix y el vector elemental \mathbf{b}_i como gsl_vector almacenados en los apuntadores globales dentro de la estructura feenox.fem:

// elemental (local) objects

gsl_matrix *Ki; // elementary stiffness matrix

gsl_matrix *Mi; // elementary mass matrix

gsl_matrix *JKi; // elementary jacobian for stiffness matrix

gsl_matrix *Jbi; // elementary jacobian for RHS vector

gsl_vector *bi; // elementary right-hand side vectorObservación. Las matrices jacobianas son necesarias para problemas no lineales resueltos con SNES.

Para el caso de difusión de neutrones, las dos funciones que construyen los objetos elementales son

int feenox_problem_build_volumetric_neutron_diffusion(element_t *e) {

if (neutron_diffusion.space_XS == 0) {

feenox_call(feenox_problem_neutron_diffusion_eval_XS(feenox_fem_get_material(e), NULL));

}

return FEENOX_OK;

}

int feenox_problem_build_volumetric_gauss_point_neutron_diffusion(element_t *e, unsigned int q) {

if (neutron_diffusion.space_XS != 0) {

double *x = feenox_fem_compute_x_at_gauss(e, q, feenox.pde.mesh->integration);

feenox_call(feenox_problem_neutron_diffusion_eval_XS(feenox_fem_get_material(e), x));

}

// elemental stiffness for the diffusion term B'*D*B

double wdet = feenox_fem_compute_w_det_at_gauss(e, q, feenox.pde.mesh->integration);

gsl_matrix *B = feenox_fem_compute_B_G_at_gauss(e, q, feenox.pde.mesh->integration);

feenox_call(feenox_blas_BtCB(B, neutron_diffusion.D_G, neutron_diffusion.DB, wdet, neutron_diffusion.Li));

// elemental scattering H'*A*H

gsl_matrix *H = feenox_fem_compute_H_Gc_at_gauss(e, q, feenox.pde.mesh->integration);

feenox_call(feenox_blas_BtCB(H, neutron_diffusion.R, neutron_diffusion.RH, wdet, neutron_diffusion.Ai));

// elemental fission matrix

if (neutron_diffusion.has_fission) {

feenox_call(feenox_blas_BtCB(H, neutron_diffusion.X, neutron_diffusion.XH, wdet, neutron_diffusion.Fi));

}

if (neutron_diffusion.has_sources) {

feenox_call(feenox_blas_Atb_accum(H, neutron_diffusion.s, wdet, feenox.fem.bi));

}

// for source-driven problems

// Ki = Li + Ai - Xi

// for criticallity problems

// Ki = Li + Ai

// Mi = Xi

feenox_call(gsl_matrix_add(neutron_diffusion.Li, neutron_diffusion.Ai));

if (neutron_diffusion.has_fission) {

if (neutron_diffusion.has_sources) {

feenox_call(gsl_matrix_scale(neutron_diffusion.Fi, -1.0));

feenox_call(gsl_matrix_add(neutron_diffusion.Li, neutron_diffusion.Fi));

} else {

feenox_call(gsl_matrix_add(feenox.fem.Mi, neutron_diffusion.Fi));

}

}

feenox_call(gsl_matrix_add(feenox.fem.Ki, neutron_diffusion.Li));

return FEENOX_OK;

}Luego de hacer el bucle sobre cada punto de Gauss q de cada elemento volumétrico e_i, el framework general se encarga de ensamblar los objetos globales \mathsf{K}, \mathsf{M} y/o \mathbf{b} en formato PETSc a partir de los objetos locales \mathsf{K}_i, \mathsf{M}_i y/o \mathbf{b}_i en formato GSL. En forma análoga, el framework hace otro bucle sobre los elementos superficiales que contienen condiciones de borde naturales y llama al apuntador a función set_natural() que toma como argumentos

un apuntador a una estructura

bc_data_tdefinida comostruct bc_data_t { char *string; enum { bc_type_math_undefined, bc_type_math_dirichlet, bc_type_math_neumann, bc_type_math_robin, bc_type_math_multifreedom } type_math; int type_phys; // problem-based flag that tells which type of BC this is // boolean flags int space_dependent; int nonlinear; int disabled; int fills_matrix; unsigned int dof; // -1 means "all" dofs expr_t expr; expr_t condition; // if it is not null the BC only applies if this evaluates to non-zero int (*set_essential)(bc_data_t *, element_t *, size_t j_global); int (*set_natural)(bc_data_t *, element_t *, unsigned int q); bc_data_t *prev, *next; // doubly-linked list in ech bc_t };que es “rellenada” por el parser específico de condiciones de contorno,

un apuntador al elemento

el índice q del punto de Gauss

Por ejemplo, la condición de contorno natural tipo vacuum de difusión de neutrones es

int feenox_problem_bc_set_neutron_diffusion_vacuum(bc_data_t *this, element_t *e, unsigned int q) {

feenox_fem_compute_x_at_gauss_if_needed_and_update_var(e, q, feenox.pde.mesh->integration, this->space_dependent);

double coeff = (this->expr.items != NULL) ? feenox_expression_eval(&this->expr) : 0.5;

double wdet = feenox_fem_compute_w_det_at_gauss(e, q, feenox.pde.mesh->integration);

gsl_matrix *H = feenox_fem_compute_H_Gc_at_gauss(e, q, feenox.pde.mesh->integration);

feenox_call(feenox_blas_BtB_accum(H, wdet*coeff, feenox.fem.Ki));

return FEENOX_OK;

}Observación. La condición de contorno tipo mirror en difusión, tal como en la ecuación de Laplace o en conducción de calor, consiste en “no hacer nada”.

Las condiciones de contorno esenciales se ponen en el problema luego de haber ensamblado la matriz global \mathsf{A} para transformarla en la matriz de rigidez \mathsf{K} según el procedimiento discutido en la Sección 3.4.1.5. Para ello debemos hacer un bucle sobre los nodos, bien con el algoritmo o con el algoritmo , y poner un uno en la diagonal de la matriz de rigidez y el valor de la condición de contorno en el nodo en el vector del miembro derecho, en la fila correspondiente al grado de libertad global.

Observación. En un problema de autovalores, sólo es posible poner condiciones de contorno homogéneas. En este caso, se puede

- poner un uno en la diagonal de \mathsf{K} y un cero en la diagonal de \mathsf{M}, ó

- poner un uno en la diagonal de \mathsf{M} y un cero en la diagonal de \mathsf{K}

Cuál de las dos opciones es la más conveniente depende del algoritmo seleccionado para la transformación espectral del problema de autovalores a resolver.

La forma de implementar esto en FeenoX para una PDE arbitraria es que para cada nodo que contiene una condición de Dirichlet, el framework llama al apuntador a función set_essential() que toma como argumentos

- un apuntador a la estructura

bc_data_t - un apuntador al elemento (estructura

element_t) - el índice j global del nodo

Para difusión, la condición null se implementa sencillamente como

int feenox_problem_bc_set_neutron_diffusion_null(bc_data_t *this, element_t *e, size_t j_global) {

for (unsigned int g = 0; g < feenox.pde.dofs; g++) {

feenox_call(feenox_problem_dirichlet_add(feenox.pde.mesh->node[j_global].index_dof[g], 0));

}

return FEENOX_OK;

}En S_N, la condición vacuum es ligeramente más compleja ya que debemos verificar que la dirección sea entrante:

int feenox_problem_bc_set_neutron_sn_vacuum(bc_data_t *this, element_t *e, size_t j_global) {

double outward_normal[3];

feenox_call(feenox_mesh_compute_outward_normal(e, outward_normal));

for (unsigned m = 0; m < neutron_sn.directions; m++) {

if (feenox_mesh_dot(neutron_sn.Omega[m], outward_normal) < 0) {

// if the direction is inward set it to zero

for (unsigned int g = 0; g < neutron_sn.groups; g++) {

feenox_call(feenox_problem_dirichlet_add(

feenox.pde.mesh->node[j_global].index_dof[sn_dof_index(m,g)], 0)

);

}

}

}

return FEENOX_OK;

}La condición de contorno mirror es más compleja aún porque implica condiciones multi-libertad33, que deben ser puestas en la matriz de rigidez usando

- Eliminación directa

- Método de penalidad

- Multiplicadores de Lagrange

En su versión actual, FeenoX utiliza el método de penalidad [6]. El framework provee una llamada genérica feenox_problem_multifreedom_add() donde las rutinas particulares deben “registrar” sus condiciones multi-libertad:

int feenox_problem_bc_set_neutron_sn_mirror(bc_data_t *this, element_t *e, size_t j_global) {

double outward_normal[3];

double reflected[3];

double Omega_dot_outward = 0;

double eps = feenox_var_value(feenox.mesh.vars.eps);

feenox_call(feenox_mesh_compute_outward_normal(e, outward_normal));

for (unsigned m = 0; m < neutron_sn.directions; m++) {

if ((Omega_dot_outward = feenox_mesh_dot(neutron_sn.Omega[m], outward_normal)) < 0) {

// if the direction is inward then we have to reflect it

// if Omega is the incident direction with respect to the outward normal then

// reflected = Omega - 2*(Omega dot outward_normal) * outward_normal

for (int d = 0; d < 3; d++) {

reflected[d] = neutron_sn.Omega[m][d] - 2*Omega_dot_outward * outward_normal[d];

}

unsigned int m_prime = 0;

for (m_prime = 0; m_prime < neutron_sn.directions; m_prime++) {

if (fabs(reflected[0] - neutron_sn.Omega[m_prime][0]) < eps &&

fabs(reflected[1] - neutron_sn.Omega[m_prime][1]) < eps &&

fabs(reflected[2] - neutron_sn.Omega[m_prime][2]) < eps) {

break;

}

}

if (m_prime == neutron_sn.directions) {

feenox_push_error_message("cannot find a reflected direction for m=%d (out of %d in S%d) for node %d", m, neutron_sn.directions, neutron_sn.N, feenox.pde.mesh->node[j_global].tag);

return FEENOX_ERROR;

}

double *coefficients = NULL;

feenox_check_alloc(coefficients = calloc(feenox.pde.dofs, sizeof(double)));

for (unsigned int g = 0; g < neutron_sn.groups; g++) {

coefficients[sn_dof_index(m,g)] = -1;

coefficients[sn_dof_index(m_prime,g)] = +1;

}

feenox_call(feenox_problem_multifreedom_add(j_global, coefficients));

feenox_free(coefficients);

}

}

return FEENOX_OK;

}Éstas son luego multiplicadas por un factor de penalidad y sumadas a la matriz de rigidez por el framework general.

4.1.4.4 Solución

Una vez construidos los objetos globales \mathsf{K} y/o \mathsf{M} y/o \mathbf{b}, el framework llama a feenox.pde.solve() que puede apuntar a

feenox_problem_solve_petsc_linear()feenox_problem_solve_petsc_nonlinear()feenox_problem_solve_slepc_eigen()feenox_problem_solve_petsc_transient()

según el inicializador particular de la PDE haya elegido. Por ejemplo, si la variable end_time es diferente de cero, entonces en thermal se llama a trasient(). De otra manera, si la conductividad k depende de la temperatura T, se llama a nonlinear() y si no depende de T, se llama a linear(). En el caso de neutrónica, tanto difusión como S_N, la lógica depende de si existen fuentes independientes o no:

feenox.pde.math_type = neutron_diffusion.has_sources ? math_type_linear : math_type_eigen;

feenox.pde.solve = neutron_diffusion.has_sources ? feenox_problem_solve_petsc_linear : feenox_problem_solve_slepc_eigen;

feenox.pde.has_stiffness = 1;

feenox.pde.has_mass = !neutron_diffusion.has_sources;

feenox.pde.has_rhs = neutron_diffusion.has_sources;4.1.4.5 Post-procesamiento

Luego de resolver el problema discretizado y de encontrar el vector global solución \mathbf{u}, debemos dejar disponibles la solución para que las instrucciones que siguen a SOLVE_PROBLEM, tales como las palabras clave PRINT o WRITE_RESULTS, puedan operar con ellas.

Definición 4.2 (campos principales) Las funciones del espacio que son solución de la ecuación a resolver y cuyos valores nodales provienen de los elementos del vector solución \mathbf{u} se llaman campos principales.

Definición 4.3 (campos secundarios) Las funciones del espacio que dan información sobre la solución del problema cuyos valores nodales provienen de operar algebraica, diferencial o integralmente sobre el vector solución \mathbf{u} se llaman campos secundarios.

| Problema | Campo principal | Campos secundarios |

|---|---|---|

| Conducción de calor | Temperatura | Flujos de calor |

| Elasticidad (formulación u) | Desplazamientos | Tensiones y deformaciones |

| Difusión de neutrones | Flujos escalares | Corrientes |

| Ordenadas discretas | Flujos angulares | Flujos escalares y corrientes |

La tabla 4.1 lista los campos principales y secundarios de algunos tipos de problemas físicos. Los campos principales son “rellenados” por el framework general mientras que los campos secundarios necesitan más puntos de entrada específicos para poder ser definidos.

En efecto, el framework sabe cómo “rellenar” las funciones solución a partir de \mathbf{u} mediante los índices que mapean los grados de libertad de cada nodo espacial con los índices globales. Para ello, como ya vimos, cada inicializador debe “registrar” la cantidad y el nombre de las soluciones según la cantidad de grados de libertad por nodo dado en feenox.pde.dofs.

Por ejemplo, para un problema escalar como thermal, hay un único grado de libertad por nodo por lo que debe haber una única función solución de la ecuación que el inicializador “registró” en el framework como

// thermal is a scalar problem

feenox.pde.dofs = 1;

feenox_check_alloc(feenox.pde.unknown_name = calloc(feenox.pde.dofs, sizeof(char *)));

feenox_check_alloc(feenox.pde.unknown_name[0] = strdup("T"));En difusión de neutrones, la cantidad de grados de libertad por nodo es la cantidad G de grupos de energía, leído por el parser específico en la palabra clave GROUPS. Las funciones solución son phi1, phi2, etc:

// default is 1 group

if (neutron_diffusion.groups == 0) {

neutron_diffusion.groups = 1;

}

// dofs = number of groups

feenox.pde.dofs = neutron_diffusion.groups;

feenox_check_alloc(feenox.pde.unknown_name = calloc(neutron_diffusion.groups, sizeof(char *)));

for (unsigned int g = 0; g < neutron_diffusion.groups; g++) {

feenox_check_minusone(asprintf(&feenox.pde.unknown_name[g], "phi%u", g+1));

}En S_N, la cantidad de grados de libertad por nodo es el producto entre M y G. Las funciones, como mostramos en la Sección 4.1.4.1, son psi1.1, psi2.1, etc. donde el primer índice es g y el segundo es m.

4.2 Expresiones algebraicas

Una característica distintiva de FeenoX es que en cada lugar del archivo de entrada donde se espere un valor numérico, desde la cantidad de grupos de energía después de la palabra clave GROUPS hasta las propiedades de los materiales, es posible escribir una expresión algebraica. Por ejemplo

PROBLEM neutron_diffusion DIMENSIONS 1+2 GROUPS sqrt(4)